Related articles

- Install Arch Linux on LVM

- LVM on software RAID

- dm-crypt/Encrypting an entire system#LVM on LUKS

- dm-crypt/Encrypting an entire system#LUKS on LVM

- Resizing LVM-on-LUKS

- Create root filesystem snapshots with LVM

From Wikipedia:Logical Volume Manager (Linux):

- Logical Volume Manager (LVM) is a device mapper framework that provides logical volume management for the Linux kernel.

Background

LVM building blocks

Logical Volume Management utilizes the kernel’s device-mapper feature to provide a system of partitions independent of underlying disk layout. With LVM you abstract your storage and have «virtual partitions», making extending/shrinking easier (subject to potential filesystem limitations).

Virtual partitions allow addition and removal without worry of whether you have enough contiguous space on a particular disk, getting caught up fdisking a disk in use (and wondering whether the kernel is using the old or new partition table), or, having to move other partitions out of the way.

Basic building blocks of LVM:

- Physical volume (PV)

- Unix block device node, usable for storage by LVM. Examples: a hard disk, an MBR or GPT partition, a loopback file, a device mapper device (e.g. dm-crypt). It hosts an LVM header.

- Volume group (VG)

- Group of PVs that serves as a container for LVs. PEs are allocated from a VG for a LV.

- Logical volume (LV)

- «Virtual/logical partition» that resides in a VG and is composed of PEs. LVs are Unix block devices analogous to physical partitions, e.g. they can be directly formatted with a file system.

- Physical extent (PE)

- The smallest contiguous extent (default 4 MiB) in the PV that can be assigned to a LV. Think of PEs as parts of PVs that can be allocated to any LV.

Example:

Physical disks

Disk1 (/dev/sda):

┌──────────────────────────────────────┬─────────────────────────────────────┐

│ Partition1 50 GiB (Physical volume) │ Partition2 80 GiB (Physical volume) │

│ /dev/sda1 │ /dev/sda2 │

└──────────────────────────────────────┴─────────────────────────────────────┘

Disk2 (/dev/sdb):

┌──────────────────────────────────────┐

│ Partition1 120 GiB (Physical volume) │

│ /dev/sdb1 │

└──────────────────────────────────────┘

LVM logical volumes

Volume Group1 (/dev/MyVolGroup/ = /dev/sda1 + /dev/sda2 + /dev/sdb1):

┌─────────────────────────┬─────────────────────────┬──────────────────────────┐

│ Logical volume1 15 GiB │ Logical volume2 35 GiB │ Logical volume3 200 GiB │

│ /dev/MyVolGroup/rootvol │ /dev/MyVolGroup/homevol │ /dev/MyVolGroup/mediavol │

└─────────────────────────┴─────────────────────────┴──────────────────────────┘

Note: Logical volumes are accessible at both /dev/VolumeGroupName/LogicalVolumeName and /dev/mapper/VolumeGroupName-LogicalVolumeName. However, lvm(8) § VALID NAMES recommends the former format for «software and scripts» (e.g. fstab) since the latter is intended for «internal use» and subject to possible «change between releases and distributions».

Advantages

LVM gives you more flexibility than just using normal hard drive partitions:

- Use any number of disks as one big disk.

- Have logical volumes stretched over several disks.

- Create small logical volumes and resize them «dynamically» as they get filled up.

- Resize logical volumes regardless of their order on disk. It does not depend on the position of the LV within VG, there is no need to ensure surrounding available space.

- Resize/create/delete logical and physical volumes online. File systems on them still need to be resized, but some (such as ext4) support online resizing.

- Online/live migration of LV being used by services to different disks without having to restart services.

- Snapshots allow you to backup a frozen copy of the file system, while keeping service downtime to a minimum.

- Support for unlocking separate volumes without having to enter a key multiple times on boot (make LVM on top of LUKS).

- Built-in support for caching of frequently used data (lvmcache(7)).

Disadvantages

- Additional steps in setting up the system, more complicated. Requires (multiple) daemons to constantly run.

- If dual-booting, note that Windows does not support LVM; you will be unable to access any LVM partitions from Windows. 3rd Party software may allow to mount certain kinds of LVM setups. [1]

- If your physical volumes are not on a RAID-1, RAID-5 or RAID-6 losing one disk can lose one or more logical volumes if you span (or extend) your logical volumes across multiple non-redundant disks.

- You cannot (easily) shrink the space used by the logical volume manager, meaning the physical volumes used for the logical volumes. If the physical extents are scattered across the physical volume until the end, it is not possible to shrink the physical volume with the scripts provided on the Arch Wiki. If you want to dual-boot with other operating systems (e.g. with Microsoft Windows), the only space left on the device for Microsoft Windows is the space not used by LVM / not used as physical volume.

Installation

Make sure the lvm2 package is installed.

If you have LVM volumes not activated via the initramfs, enable lvm2-monitor.service, which is provided by the lvm2 package.

Volume operations

Physical volumes

Creating

To create a PV on /dev/sda1, run:

# pvcreate /dev/sda1

You can check the PV is created using the following command:

# pvs

Growing

After extending or prior to reducing the size of a device that has a physical volume on it, you need to grow or shrink the PV using pvresize(8).

To expand the PV on /dev/sda1 after enlarging the partition, run:

# pvresize /dev/sda1

This will automatically detect the new size of the device and extend the PV to its maximum.

Note: This command can be done while the volume is online.

Shrinking

To shrink a physical volume prior to reducing its underlying device, add the --setphysicalvolumesize size parameters to the command, e.g.:

# pvresize --setphysicalvolumesize 40G /dev/sda1

The above command may leave you with this error:

/dev/sda1: cannot resize to 25599 extents as later ones are allocated. 0 physical volume(s) resized / 1 physical volume(s) not resized

Indeed pvresize will refuse to shrink a PV if it has allocated extents after where its new end would be. One needs to run pvmove beforehand to relocate these elsewhere in the volume group if there is sufficient free space.

Move physical extents

Before moving free extents to the end of the volume, one must run pvdisplay -v -m to see physical segments. In the below example, there is one physical volume on /dev/sdd1, one volume group vg1 and one logical volume backup.

# pvdisplay -v -m

Finding all volume groups.

Using physical volume(s) on command line.

--- Physical volume ---

PV Name /dev/sdd1

VG Name vg1

PV Size 1.52 TiB / not usable 1.97 MiB

Allocatable yes

PE Size 4.00 MiB

Total PE 399669

Free PE 153600

Allocated PE 246069

PV UUID MR9J0X-zQB4-wi3k-EnaV-5ksf-hN1P-Jkm5mW

--- Physical Segments ---

Physical extent 0 to 153600:

FREE

Physical extent 153601 to 307199:

Logical volume /dev/vg1/backup

Logical extents 1 to 153599

Physical extent 307200 to 307200:

FREE

Physical extent 307201 to 399668:

Logical volume /dev/vg1/backup

Logical extents 153601 to 246068

One can observe FREE space are split across the volume. To shrink the physical volume, we must first move all used segments to the beginning.

Here, the first free segment is from 0 to 153600 and leaves us with 153601 free extents. We can now move this segment number from the last physical extent to the first extent. The command will thus be:

# pvmove --alloc anywhere /dev/sdd1:307201-399668 /dev/sdd1:0-92467

/dev/sdd1: Moved: 0.1 % /dev/sdd1: Moved: 0.2 % ... /dev/sdd1: Moved: 99.9 % /dev/sdd1: Moved: 100.0 %

Note:

- This command moves 399668 — 307201 + 1 = 92468 PEs from the last segment to the first segment. This is possible as the first segment encloses 153600 free PEs, which can contain the 92467 — 0 + 1 = 92468 moved PEs.

- The

--alloc anywhereoption is used as we move PEs inside the same partition. In case of different partitions, the command would look something like this:# pvmove /dev/sdb1:1000-1999 /dev/sdc1:0-999

- This command may take a long time (one to two hours) in case of large volumes. It might be a good idea to run this command in a tmux or GNU Screen session. Any unwanted stop of the process could be fatal.

- Once the operation is complete, run fsck to make sure your file system is valid.

Resize physical volume

Once all your free physical segments are on the last physical extents, run vgdisplay with root privileges and see your free PE.

Then you can now run again the command:

# pvresize --setphysicalvolumesize size PhysicalVolume

See the result:

# pvs

PV VG Fmt Attr PSize PFree /dev/sdd1 vg1 lvm2 a-- 1t 500g

Resize partition

Last, you need to shrink the partition with your favorite partitioning tool.

Volume groups

Creating a volume group

To create a VG MyVolGroup with an associated PV /dev/sdb1, run:

# vgcreate MyVolGroup /dev/sdb1

You can check the VG MyVolGroup is created using the following command:

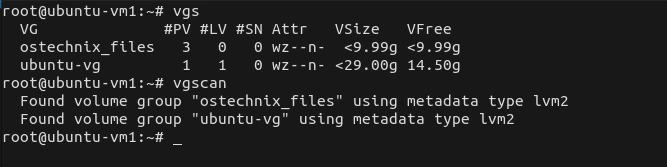

# vgs

You can bind multiple PVs when creating a VG like this:

# vgcreate MyVolGroup /dev/sdb1 /dev/sdb2

Activating a volume group

Note: You can restrict the volumes that are activated automatically by setting the auto_activation_volume_list in /etc/lvm/lvm.conf. If in doubt, leave this option commented out.

# vgchange -a y MyVolGroup

By default, this will reactivate the volume group when applicable. For example, if you had a drive failure in a mirror and you swapped the drive; and ran (1) pvcreate, (2) vgextend and (3) vgreduce --removemissing --force.

Repairing a volume group

To start the rebuilding process of the degraded mirror array in this example, you would run:

# lvconvert --repair /dev/MyVolGroup/mirror

You can monitor the rebuilding process (Cpy%Sync Column output) with:

# lvs -a -o +devices

Deactivating a volume group

Just invoke

# vgchange -a n MyVolGroup

This will deactivate the volume group and allow you to unmount the container it is stored in.

Renaming a volume group

Use the vgrename(8) command to rename an existing volume group.

Either of the following commands renames the existing volume group MyVolGroup to my_volume_group

# vgrename /dev/MyVolGroup /dev/my_volume_group

# vgrename MyVolGroup my_volume_group

Make sure to update all configuration files (e.g. /etc/fstab or /etc/crypttab) that reference the renamed volume group.

Add physical volume to a volume group

You first create a new physical volume on the block device you wish to use, then extend your volume group

# pvcreate /dev/sdb1 # vgextend MyVolGroup /dev/sdb1

This of course will increase the total number of physical extents on your volume group, which can be allocated by logical volumes as you see fit.

Note: It is considered good form to have a partition table on your storage medium below LVM. Use the appropriate partition type: 8e for MBR, and E6D6D379-F507-44C2-A23C-238F2A3DF928 for GPT partitions.

Remove partition from a volume group

If you created a logical volume on the partition, remove it first.

All of the data on that partition needs to be moved to another partition. Fortunately, LVM makes this easy:

# pvmove /dev/sdb1

If you want to have the data on a specific physical volume, specify that as the second argument to pvmove:

# pvmove /dev/sdb1 /dev/sdf1

Then the physical volume needs to be removed from the volume group:

# vgreduce MyVolGroup /dev/sdb1

Or remove all empty physical volumes:

# vgreduce --all MyVolGroup

For example: if you have a bad disk in a group that cannot be found because it has been removed or failed:

# vgreduce --removemissing --force MyVolGroup

And lastly, if you want to use the partition for something else, and want to avoid LVM thinking that the partition is a physical volume:

# pvremove /dev/sdb1

Logical volumes

Note: lvresize(8) provides more or less the same options as the specialized lvextend(8) and lvreduce(8) commands, while allowing to do both types of operation. Notwithstanding this, all those utilities offer a -r/--resizefs option which allows to resize the file system together with the LV using fsadm(8) (ext2, ext3, ext4, ReiserFS and XFS supported). Therefore it may be easier to simply use lvresize for both operations and use --resizefs to simplify things a bit, except if you have specific needs or want full control over the process.

Warning: While enlarging a file system can often be done on-line (i.e. while it is mounted), even for the root partition, shrinking will nearly always require to first unmount the file system so as to prevent data loss. Make sure your file system supports what you are trying to do.

Tip: If a logical volume will be formatted with ext4, leave at least 256 MiB free space in the volume group to allow using e2scrub(8). After creating the last volume with -l 100%FREE, this can be accomplished by reducing its size with lvreduce -L -256M volume_group/logical_volume.

Creating a logical volume

To create a LV homevol in a VG MyVolGroup with 300 GiB of capacity, run:

# lvcreate -L 300G MyVolGroup -n homevol

or, to create a LV homevol in a VG MyVolGroup with the rest of capacity, run:

# lvcreate -l 100%FREE MyVolGroup -n homevol

The new LV will appear as /dev/MyVolGroup/homevol. Now you can format the LV with an appropriate file system.

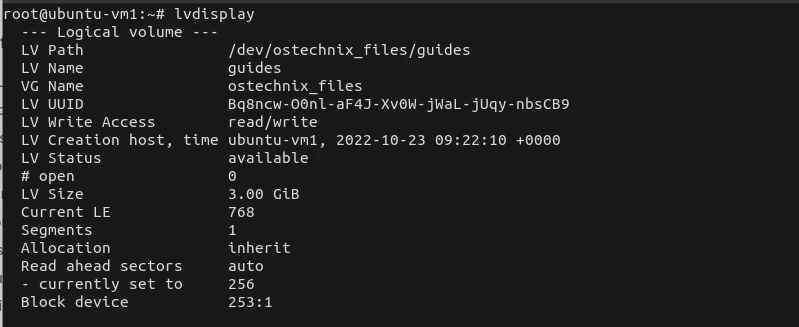

You can check the LV is created using the following command:

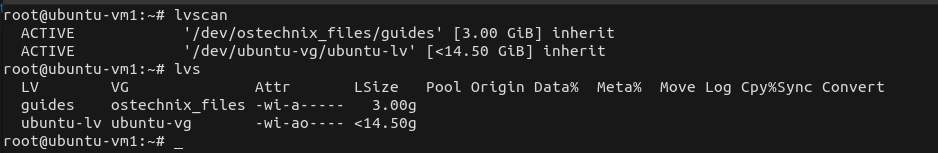

# lvs

Renaming a logical volume

To rename an existing logical volume, use the lvrename(8) command.

Either of the following commands renames logical volume old_vol in volume group MyVolGroup to new_vol.

# lvrename /dev/MyVolGroup/old_vol /dev/MyVolGroup/new_vol

# lvrename MyVolGroup old_vol new_vol

Make sure to update all configuration files (e.g. /etc/fstab or /etc/crypttab) that reference the renamed logical volume.

Resizing the logical volume and file system in one go

Note: Only ext2, ext3, ext4, ReiserFS and XFS file systems are supported. For a different type of file system see #Resizing the logical volume and file system separately.

Extend the logical volume mediavol in MyVolGroup by 10 GiB and resize its file system all at once:

# lvresize -L +10G --resizefs MyVolGroup/mediavol

Set the size of logical volume mediavol in MyVolGroup to 15 GiB and resize its file system all at once:

# lvresize -L 15G --resizefs MyVolGroup/mediavol

If you want to fill all the free space on a volume group, use the following command:

# lvresize -l +100%FREE --resizefs MyVolGroup/mediavol

See lvresize(8) for more detailed options.

Resizing the logical volume and file system separately

For file systems not supported by fsadm(8) will need to use the appropriate utility to resize the file system before shrinking the logical volume or after expanding it.

To extend logical volume mediavol within volume group MyVolGroup by 2 GiB without touching its file system:

# lvresize -L +2G MyVolGroup/mediavol

Now expand the file system (ext4 in this example) to the maximum size of the underlying logical volume:

# resize2fs /dev/MyVolGroup/mediavol

To reduce the size of logical volume mediavol in MyVolGroup by 500 MiB, first calculate the resulting file system size and shrink the file system (ext4 in this example) to the new size:

# resize2fs /dev/MyVolGroup/mediavol NewSize

When the file system is shrunk, reduce the size of logical volume:

# lvresize -L -500M MyVolGroup/mediavol

To calculate the exact logical volume size for ext2, ext3, ext4 file systems, use a simple formula: LVM_EXTENTS = FS_BLOCKS × FS_BLOCKSIZE ÷ LVM_EXTENTSIZE.

# tune2fs -l /dev/MyVolGroup/mediavol | grep Block

Block count: 102400000 Block size: 4096 Blocks per group: 32768

# vgdisplay MyVolGroup | grep "PE Size"

PE Size 4.00 MiB

Note: The file system block size is in bytes. Make sure to use the same units for both block and extent size.

102400000 blocks × 4096 bytes/block ÷ 4 MiB/extent = 100000 extents

Passing --resizefs will confirm that the correctness.

# lvreduce -l 100000 --resizefs /dev/MyVolGroup/mediavol

... The filesystem is already 102400000 (4k) blocks long. Nothing to do! ... Logical volume sysvg/root successfully resized.

See lvresize(8) for more detailed options.

Removing a logical volume

Warning: Before you remove a logical volume, make sure to move all data that you want to keep somewhere else; otherwise, it will be lost!

First, find out the name of the logical volume you want to remove. You can get a list of all logical volumes with:

# lvs

Next, look up the mountpoint of the chosen logical volume:

$ lsblk

Then unmount the filesystem on the logical volume:

# umount /mountpoint

Finally, remove the logical volume:

# lvremove volume_group/logical_volume

For example:

# lvremove MyVolGroup/homevol

Confirm by typing in y.

Make sure to update all configuration files (e.g. /etc/fstab or /etc/crypttab) that reference the removed logical volume.

You can verify the removal of the logical volume by typing lvs as root again (see first step of this section).

Snapshots

LVM supports CoW (Copy-on-Write) snapshots. A CoW snapshot initially points to the original data. When data blocks are overwritten, the original copy is left intact and the new blocks are written elsewhere on-disk. This has several desirable properties:

- Creating snapshots is fast, because it does not copy data (just the much shorter list of pointers to the on-disk locations).

- Snapshots require just enough free space to hold the new data blocks (plus a negligible amount for the pointers to the new blocks). For example, a snapshot of 35 GiB of data, where you write only 2 GiB (on both the original and snapshot), only requires 2 GiB of free space.

LVM snapshots are at the block level. They make a new block device, with no apparent relationship to the original except when dealing with the LVM tools. Therefore, deleting files in the original copy does not free space in the snapshots. If you need filesystem-level snapshots, you rather need btrfs, ZFS or bcache.

Warning:

- A CoW snapshot is not a backup, because it does not make a second copy of the original data. For example, a damaged disk sector that affects original data also affects the snapshots. That said, a snapshot can be helpful while using other tools to make backups, as outlined below.

- Btrfs expects different filesystems to have different UUIDs. If you snapshot a LVM volume that contains a btrfs filesystem, make sure to change the UUID of the original or the copy, before both are mounted (or made visible to the kernel, for example if an unrelated daemon triggers a btrfs device scan). For details see btrfs wiki Gotcha’s.

Configuration

You create snapshot logical volumes just like normal ones.

# lvcreate --size 100M --snapshot --name snap01vol /dev/MyVolGroup/lvol

With that volume, you may modify less than 100 MiB of data, before the snapshot volume fills up.

Reverting the modified lvol logical volume to the state when the snap01vol snapshot was taken can be done with

# lvconvert --merge /dev/MyVolGroup/snap01vol

In case the origin logical volume is active, merging will occur on the next reboot (merging can be done even from a LiveCD).

Note: The snapshot will no longer exist after merging.

Also multiple snapshots can be taken and each one can be merged with the origin logical volume at will.

Backups

A snapshot provides a frozen copy of a file system to make backups. For example, a backup taking two hours provides a more consistent image of the file system than directly backing up the partition.

The snapshot can be mounted and backed up with dd or tar. The size of the backup file done with dd will be the size of the files residing on the snapshot volume.

To restore just create a snapshot, mount it, and write or extract the backup to it. And then merge it with the origin.

See Create root filesystem snapshots with LVM for automating the creation of clean root file system snapshots during system startup for backup and rollback.

This article or section needs expansion.

Reason: Show scripts to automate snapshots of root before updates, to rollback… updating menu.lst to boot snapshots (maybe in a separate article?) (Discuss in Talk:LVM)

Encryption

See dm-crypt/Encrypting an entire system#LUKS on LVM and dm-crypt/Encrypting an entire system#LVM on LUKS for the possible schemes of combining LUKS with LVM.

Cache

From lvmcache(7):

- The cache logical volume type uses a small and fast LV to improve the performance of a large and slow LV. It does this by storing the frequently used blocks on the faster LV. LVM refers to the small fast LV as a cache pool LV. The large slow LV is called the origin LV. Due to requirements from dm-cache (the kernel driver), LVM further splits the cache pool LV into two devices — the cache data LV and cache metadata LV. The cache data LV is where copies of data blocks are kept from the origin LV to increase speed. The cache metadata LV holds the accounting information that specifies where data blocks are stored (e.g. on the origin LV or on the cache data LV). Users should be familiar with these LVs if they wish to create the best and most robust cached logical volumes. All of these associated LVs must be in the same VG.

Create cache

Convert your fast disk (/dev/fastdisk) to PV and add to your existing VG (MyVolGroup):

# vgextend MyVolGroup /dev/fastdisk

Create a cache pool with automatic meta data on /dev/fastdisk and convert the existing LV MyVolGroup/rootvol to a cached volume, all in one step:

# lvcreate --type cache --cachemode writethrough -l 100%FREE -n root_cachepool MyVolGroup/rootvol /dev/fastdisk

Tip: Instead of using -l 100%FREE to allocate 100% of available space from PV /dev/fastdisk, you can use -L 20G instead to allocate only 20 GiB for cachepool.

Cachemode has two possible options:

writethroughensures that any data written will be stored both in the cache pool LV and on the origin LV. The loss of a device associated with the cache pool LV in this case would not mean the loss of any data;writebackensures better performance, but at the cost of a higher risk of data loss in case the drive used for cache fails.

If a specific --cachemode is not indicated, the system will assume writethrough as default.

Remove cache

If you ever need to undo the one step creation operation above:

# lvconvert --uncache MyVolGroup/rootvol

This commits any pending writes still in the cache back to the origin LV, then deletes the cache. Other options are available and described in lvmcache(7).

RAID

LVM may be used to create a software RAID. It is a good choice if the user does not have hardware RAID and was planning on using LVM anyway. From lvmraid(7):

- lvm(8) RAID is a way to create a Logical Volume (LV) that uses multiple physical devices to improve performance or tolerate device failures. In LVM, the physical devices are Physical Volumes (PVs) in a single Volume Group (VG).

LVM RAID supports RAID 0, RAID 1, RAID 4, RAID 5, RAID 6 and RAID 10. See Wikipedia:Standard RAID levels for details on each level.

Warning: When using the lvm2 mkinitcpio hook, make sure to include the RAID kernel modules in the initramfs. This must be done regardless whether the root volume is on LVM RAID or not, as after boot pvscan will not retry activating devices it could not activate in the initramfs phase. See FS#71385.

Tip: mdadm may also be used to create a software RAID. It is arguably simpler, more popular, and easier to setup.

Setup RAID

Create physical volumes:

# pvcreate /dev/sda2 /dev/sdb2

Create volume group on the physical volumes:

# vgcreate MyVolGroup /dev/sda2 /dev/sdb2

Create logical volumes using lvcreate --type raidlevel, see lvmraid(7) and lvcreate(8) for more options.

# lvcreate --type RaidLevel [OPTIONS] -n Name -L Size VG [PVs]

For example:

# lvcreate --type raid1 --mirrors 1 -L 20G -n myraid1vol MyVolGroup /dev/sda2 /dev/sdb2

will create a 20 GiB mirrored logical volume named «myraid1vol» in VolGroup00 on /dev/sda2 and /dev/sdb2.

Thin provisioning

Note: When mounting a thin LV file system, always remember to use the discard option or to use fstrim regularly, to allow the thin LV to shrink as files are deleted.

From lvmthin(7):

- Blocks in a standard lvm(8) Logical Volume (LV) are allocated when the LV is created, but blocks in a thin provisioned LV are allocated as they are written. Because of this, a thin provisioned LV is given a virtual size, and can then be much larger than physically available storage. The amount of physical storage provided for thin provisioned LVs can be increased later as the need arises.

Example: implementing virtual private servers

Here is the classic use case. Suppose you want to start your own VPS service, initially hosting about 100 VPSes on a single PC with a 930 GiB hard drive. Hardly any of the VPSes will actually use all of the storage they are allotted, so rather than allocate 9 GiB to each VPS, you could allow each VPS a maximum of 30 GiB and use thin provisioning to only allocate as much hard drive space to each VPS as they are actually using. Suppose the 930 GiB hard drive is /dev/sdb. Here is the setup.

Prepare the volume group, MyVolGroup.

# vgcreate MyVolGroup /dev/sdb

Create the thin pool LV, MyThinPool. This LV provides the blocks for storage.

# lvcreate --type thin-pool -n MyThinPool -l 95%FREE MyVolGroup

The thin pool is composed of two sub-volumes, the data LV and the metadata LV. This command creates both automatically. But the thin pool stops working if either fills completely, and LVM currently does not support the shrinking of either of these volumes. This is why the above command allows for 5% of extra space, in case you ever need to expand the data or metadata sub-volumes of the thin pool.

For each VPS, create a thin LV. This is the block device exposed to the user for their root partition.

# lvcreate -n SomeClientsRoot -V 30G --thinpool MyThinPool MyVolGroup

The block device /dev/MyVolGroup/SomeClientsRoot may then be used by a VirtualBox instance as the root partition.

Use thin snapshots to save more space

Thin snapshots are much more powerful than regular snapshots, because they are themselves thin LVs. See Red Hat’s guide [2] for a complete list of advantages thin snapshots have.

Instead of installing Linux from scratch every time a VPS is created, it is more space-efficient to start with just one thin LV containing a basic installation of Linux:

# lvcreate -n GenericRoot -V 30G --thinpool MyThinPool MyVolGroup *** install Linux at /dev/MyVolGroup/GenericRoot ***

Then create snapshots of it for each VPS:

# lvcreate -s MyVolGroup/GenericRoot -n SomeClientsRoot

This way, in the thin pool there is only one copy the data common to all VPSes, at least initially. As an added bonus, the creation of a new VPS is instantaneous.

Since these are thin snapshots, a write operation to GenericRoot only causes one COW operation in total, instead of one COW operation per snapshot. This allows you to update GenericRoot more efficiently than if each VPS were a regular snapshot.

Example: zero-downtime storage upgrade

There are applications of thin provisioning outside of VPS hosting. Here is how you may use it to grow the effective capacity of an already-mounted file system without having to unmount it. Suppose, again, that the server has a single 930 GiB hard drive. The setup is the same as for VPS hosting, only there is only one thin LV and the LV’s size is far larger than the thin pool’s size.

# lvcreate -n MyThinLV -V 16T --thinpool MyThinPool MyVolGroup

This extra virtual space can be filled in with actual storage at a later time by extending the thin pool.

Suppose some time later, a storage upgrade is needed, and a new hard drive, /dev/sdc, is plugged into the server. To upgrade the thin pool’s capacity, add the new hard drive to the VG:

# vgextend MyVolGroup /dev/sdc

Now, extend the thin pool:

# lvextend -l +95%FREE MyVolGroup/MyThinPool

Since this thin LV’s size is 16 TiB, you could add another 15.09 TiB of hard drive space before finally having to unmount and resize the file system.

Note: You will probably want to use reserved blocks or a disk quota to prevent applications from attempting to use more physical storage than there actually is.

Troubleshooting

LVM commands do not work

- Load proper module:

# modprobe dm_mod

The dm_mod module should be automatically loaded. In case it does not, explicitly load the module at boot.

- Try preceding commands with lvm like this:

# lvm pvdisplay

Logical Volumes do not show up

If you are trying to mount existing logical volumes, but they do not show up in lvscan, you can use the following commands to activate them:

# vgscan # vgchange -ay

LVM on removable media

Symptoms:

# vgscan

Reading all physical volumes. This may take a while... /dev/backupdrive1/backup: read failed after 0 of 4096 at 319836585984: Input/output error /dev/backupdrive1/backup: read failed after 0 of 4096 at 319836643328: Input/output error /dev/backupdrive1/backup: read failed after 0 of 4096 at 0: Input/output error /dev/backupdrive1/backup: read failed after 0 of 4096 at 4096: Input/output error Found volume group "backupdrive1" using metadata type lvm2 Found volume group "networkdrive" using metadata type lvm2

Cause: removing an external LVM drive without deactivating the volume group(s) first. Before you disconnect, make sure to:

# vgchange -an volume group name

Fix: assuming you already tried to activate the volume group with vgchange -ay vg, and are receiving the Input/output errors:

# vgchange -an volume group name

Unplug the external drive and wait a few minutes:

# vgscan # vgchange -ay volume group name

Suspend/resume with LVM and removable media

The factual accuracy of this article or section is disputed.

Reason: Provided solution will not work in more complex setups like LUKS on LVM. (Discuss in Talk:LVM#LVM on removable media)

In order for LVM to work properly with removable media – like an external USB drive – the volume group of the external drive needs to be deactivated before suspend. If this is not done, you may get buffer I/O errors on the dm device (after resume). For this reason, it is not recommended to mix external and internal drives in the same volume group.

To automatically deactivate the volume groups with external USB drives, tag each volume group with the sleep_umount tag in this way:

# vgchange --addtag sleep_umount vg_external

Once the tag is set, use the following unit file for systemd to properly deactivate the volumes before suspend. On resume, they will be automatically activated by LVM.

/etc/systemd/system/ext_usb_vg_deactivate.service

[Unit] Description=Deactivate external USB volume groups on suspend Before=sleep.target [Service] Type=oneshot ExecStart=-/etc/systemd/system/deactivate_sleep_vgs.sh [Install] WantedBy=sleep.target

and this script:

/etc/systemd/system/deactivate_sleep_vgs.sh

#!/bin/sh

TAG=@sleep_umount

vgs=$(vgs --noheadings -o vg_name $TAG)

echo "Deactivating volume groups with $TAG tag: $vgs"

# Unmount logical volumes belonging to all the volume groups with tag $TAG

for vg in $vgs; do

for lv_dev_path in $(lvs --noheadings -o lv_path -S lv_active=active,vg_name=$vg); do

echo "Unmounting logical volume $lv_dev_path"

umount $lv_dev_path

done

done

# Deactivate volume groups tagged with sleep_umount

for vg in $vgs; do

echo "Deactivating volume group $vg"

vgchange -an $vg

done

Finally, enable the unit.

Resizing a contiguous logical volume fails

If trying to extend a logical volume errors with:

" Insufficient suitable contiguous allocatable extents for logical volume "

The reason is that the logical volume was created with an explicit contiguous allocation policy (options -C y or --alloc contiguous) and no further adjacent contiguous extents are available.[3]

To fix this, prior to extending the logical volume, change its allocation policy with lvchange --alloc inherit logical_volume. If you need to keep the contiguous allocation policy, an alternative approach is to move the volume to a disk area with sufficient free extents. See [4].

Command «grub-mkconfig» reports «unknown filesystem» errors

Make sure to remove snapshot volumes before generating grub.cfg.

Thinly-provisioned root volume device times out

With a large number of snapshots, thin_check runs for a long enough time so that waiting for the root device times out. To compensate, add the rootdelay=60 kernel boot parameter to your boot loader configuration. Or, make thin_check skip checking block mappings (see [5]) and regenerate the initramfs:

/etc/lvm/lvm.conf

thin_check_options = [ "-q", "--clear-needs-check-flag", "--skip-mappings" ]

Delay on shutdown

If you use RAID, snapshots or thin provisioning and experience a delay on shutdown, make sure lvm2-monitor.service is started. See FS#50420.

Hibernating into a thinly-provisioned swap volume

See Power management/Suspend and hibernate#Hibernation into a thinly-provisioned LVM volume.

See also

- LVM2 Resource Page on SourceWare.org

- Gentoo:LVM

- Red Hat Enterprise 9: Configuring and managing logical volumes

- Ubuntu LVM Guide Part 1Part 2 details snapshots

Тематические термины: LVM, Linux.

В статье описаны основные моменты использования LVM для организации дисковой системы в Linux. Она поможет как чайникам разобраться с принципами ее работы, так и уже знающим LVM в качестве шпаргалки.

Используемые команды одинаково подойдут как для систем Red Hat / CentOS, так и Debian / Ubuntu.

Уровни абстракции

Установка LVM

Создание разделов

Инициализация (pvcreate)

Создание групп (vgcreate)

Создание логического тома (lvcreate)

Файловая система и монтирование

Создание файловой системы

Монтирование тома

Просмотр информации об LVM

Увеличение томов

Расширение физического раздела

Добавление диска к группе

Увеличение логического тома

Изменение размера файловой системы

Уменьшение томов

Удаление томов

Зеркалирование

Снапшоты

Импорт диска из другой системы

Работа с LVM в Windows

Возможные ошибки

Уровни абстракции

Работа с томами с помощью LVM происходит на 3-х уровнях абстракции:

- Физический уровень (PV). Сначала диск инициализируется командой pvcreate — в начале диска создается дескриптор группы томов. При этом важно заметить, что диск не обязательно должен быть физическим — мы можно отметить на использование обычный раздел диска.

- Группа томов (VG). С помощью команды vgcreate создается группа томов из инициализированных на предыдущем этапе дисков.

- Логический том (LV). Группы томов нарезаются на логические тома командой lvcreate.

Схематично, уровни можно представить так:

Установка

Для работы с LVM необходима установка одноименной утилиты. В системе Linux она может быть установлена по умолчанию. Но если ее нет, выполняем инструкцию ниже.

Если используем системы на безе deb (Ubuntu, Debian, Mint):

apt-get install lvm2

Если используем системы на безе RPM (Red Hat, CentOS, Fedora):

yum install lvm2

Создание разделов

Рассмотрим пример создания томов из дисков sdb и sdc с помощью LVM.

1. Инициализация

Помечаем диски, что они будут использоваться для LVM:

pvcreate /dev/sdb /dev/sdc

* напомним, что в качестве примера нами используются диски sdb и sdc.

Посмотреть, что диск может использоваться LMV можно командой:

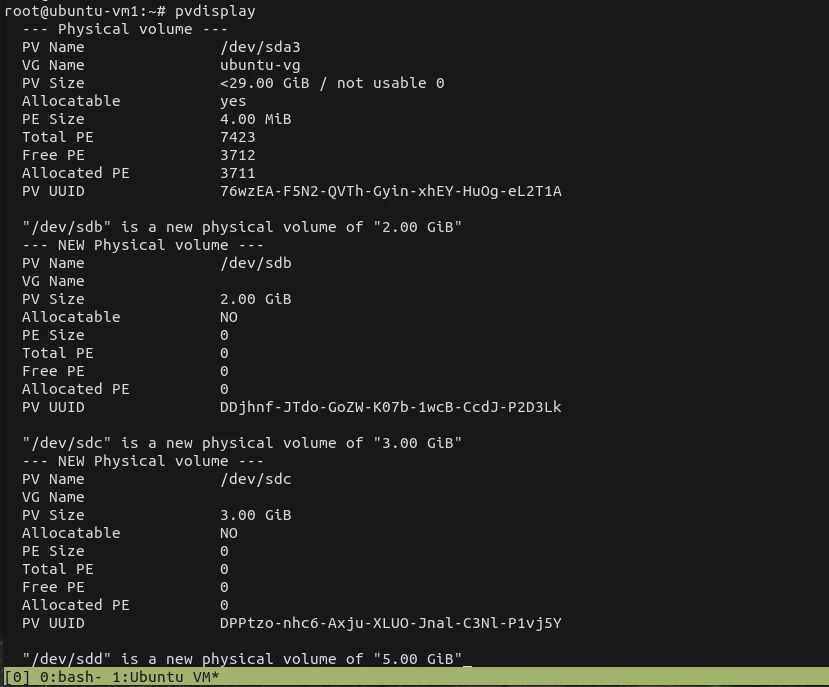

pvdisplay

В нашем случае мы должны увидеть что-то на подобие:

«/dev/sdb» is a new physical volume of «1,00 GiB»

— NEW Physical volume —

PV Name /dev/sdb

VG Name

PV Size 1,00 GiB

Allocatable NO

PE Size 0

Total PE 0

Free PE 0

Allocated PE 0

PV UUID rR8qya-eJes-7AC5-wuxv-CT7a-o30m-bnUrWa

«/dev/sdc» is a new physical volume of «1,00 GiB»

— NEW Physical volume —

PV Name /dev/sdc

VG Name

PV Size 1,00 GiB

Allocatable NO

PE Size 0

Total PE 0

Free PE 0

Allocated PE 0

PV UUID 2jIgFd-gQvH-cYkf-9K7N-M7cB-WWGE-9dzHIY

* где

- PV Name — имя диска.

- VG Name — группа томов, в которую входит данный диск (в нашем случае пусто, так как мы еще не добавили его в группу).

- PV Size — размер диска.

- Allocatable — распределение по группам. Если NO, то диск еще не задействован и его необходимо для использования включить в группу.

- PE Size — размер физического фрагмента (экстента). Пока диск не добавлен в группу, значение будет 0.

- Total PE — количество физических экстентов.

- Free PE — количество свободных физических экстентов.

- Allocated PE — распределенные экстенты.

- PV UUID — идентификатор физического раздела.

2. Создание групп томов

Инициализированные на первом этапе диски должны быть объединены в группы.

Группа может быть создана:

vgcreate vg01 /dev/sdb /dev/sdc

* где vg01 — произвольное имя создаваемой группы; /dev/sdb, /dev/sdc — наши диски.

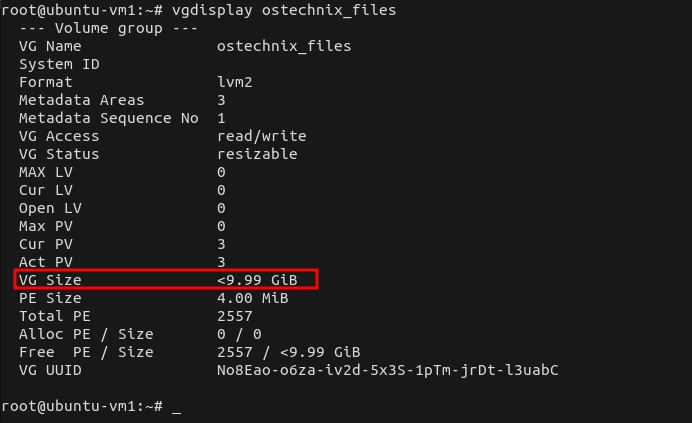

Просмотреть информацию о созданных группах можно командой:

vgdisplay

На что мы получим, примерно, следующее:

— Volume group —

VG Name vg01

System ID

Format lvm2

Metadata Areas 2

Metadata Sequence No 1

VG Access read/write

VG Status resizable

MAX LV 0

Cur LV 0

Open LV 0

Max PV 0

Cur PV 2

Act PV 2

VG Size 1,99 GiB

PE Size 4,00 MiB

Total PE 510

Alloc PE / Size 0 / 0

Free PE / Size 510 / 1,99 GiB

VG UUID b0FAUz-wlXt-Hzqz-Sxs4-oEgZ-aquZ-jLzfKz

* где:

- VG Name — имя группы.

- Format — версия подсистемы, используемая для создания группы.

- Metadata Areas — область размещения метаданных. Увеличивается на единицу с созданием каждой группы.

- VG Access — уровень доступа к группе томов.

- VG Size — суммарный объем всех дисков, которые входят в группу.

- PE Size — размер физического фрагмента (экстента).

- Total PE — количество физических экстентов.

- Alloc PE / Size — распределенное пространство: колическтво экстентов / объем.

- Free PE / Size — свободное пространство: колическтво экстентов / объем.

- VG UUID — идентификатор группы.

3. Создание логических томов

Последний этап — создание логического раздела их группы томов командой lvcreate. Ее синтаксис:

lvcreate [опции] <имя группы томов>

Примеры создания логических томов:

lvcreate -L 1G vg01

* создание тома на 1 Гб из группы vg01.

lvcreate -L50 -n lv01 vg01

* создание тома с именем lv01 на 50 Мб из группы vg01.

lvcreate -l 40%VG vg01

* при создании тома используется 40% от дискового пространства группы vg01.

lvcreate -l 100%FREE -n lv01 vg01

* использовать все свободное пространство группы vg01 при создании логического тома.

* также можно использовать %PVS — процент места от физического тома (PV); %ORIGIN — размер оригинального тома (применяется для снапшотов).

Посмотрим информацию о созданном томе:

lvdisplay

— Logical volume —

LV Path /dev/vg01/lv01

LV Name lv01

VG Name vg01

LV UUID 4nQ2rp-7AcZ-ePEQ-AdUr-qcR7-i4rq-vDISfD

LV Write Access read/write

LV Creation host, time vln.dmosk.local, 2019-03-18 20:01:14 +0300

LV Status available

# open 0

LV Size 52,00 MiB

Current LE 13

Segments 1

Allocation inherit

Read ahead sectors auto

— currently set to 8192

Block device 253:2

* где:

- LV Path — путь к устройству логического тома.

- LV Name — имя логического тома.

- VG Name — имя группы томов.

- LV UUID — идентификатор.

- LV Write Access — уровень доступа.

- LV Creation host, time — имя компьютера и дата, когда был создан том.

- LV Size — объем дискового пространства, доступный для использования.

- Current LE — количество логических экстентов.

Создание файловой системы и монтирование тома

Чтобы начать использовать созданный том, необходимо его отформатировать, создав файловую систему и примонтировать раздел в каталог.

Файловая система

Процесс создания файловой системы на томах LVM ничем не отличается от работы с любыми другими разделами.

Например, для создания файловой системы ext4 вводим:

mkfs.ext4 /dev/vg01/lv01

* vg01 — наша группа томов; lv01 — логический том.

Для создания, например, файловой системы xfs вводим:

mkfs.xfs /dev/vg01/lv01

Монтирование

Как и в случае с файловой системой, процесс монтирования не сильно отличается от разделов, созданных другими методами.

Для разового монтирования пользуемся командой:

mount /dev/vg01/lv01 /mnt

* где /dev/vg01/lv01 — созданный нами логический том, /mnt — раздел, в который мы хотим примонтировать раздел.

Для постоянного монтирования раздела добавляем строку в fstab:

vi /etc/fstab

/dev/vg01/lv01 /mnt ext4 defaults 1 2

* в данном примере мы монтируем при загрузке системы том /dev/vg01/lv01 в каталог /mnt; используется файловая система ext4.

Проверяем настройку fstab, смонтировав раздел:

mount -a

Проверяем, что диск примонтирован:

df -hT

Просмотр информации

Разберемся, как получить информацию о дисковых накопителях в системе.

1. Для общего представления дисков, разделов и томов вводим:

lsblk

Мы получим что-то на подобие:

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 30G 0 disk

sda1 8:1 0 1G 0 part /boot

sda2 8:2 0 29G 0 part

sys-root 253:0 0 27G 0 lvm /

sys-swap 253:1 0 2G 0 lvm [SWAP]

sdb 8:16 0 1G 0 disk

vg01-lv01-real 253:3 0 1G 0 lvm

vg01-lv01 253:2 0 1G 0 lvm /mnt

vg01-sn01 253:5 0 1G 0 lvm

sdc 8:32 0 1G 0 disk

vg01-lv01-real 253:3 0 1G 0 lvm

vg01-lv01 253:2 0 1G 0 lvm /mnt

vg01-sn01 253:5 0 1G 0 lvm

vg01-sn01-cow 253:4 0 500M 0 lvm

vg01-sn01 253:5 0 1G 0 lvm

sdd 8:48 0 1G 0 disk

* как видим, команда отображает корневое блочное устройство, какие разделы из него сделаны и в какие логические тома организованы из некоторых из разделов.

2. Получить информацию о проинициализированных для LVM дисков:

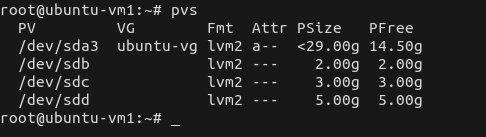

Кратко:

pvs

Подробно:

pvdisplay

pvdisplay /dev/sdb

3. Посмотреть информацию о группах LVM.

Кратко:

vgs

Подробно:

vgdisplay

vgdisplay vg01

4. Посмотреть информацию о логических томах можно также двумя способами — краткая информация:

lvs

* команда покажет все логические разделы.

Для более подробной информации о логических томах вводим:

lvdisplay

lvdisplay /dev/vg01/lv01

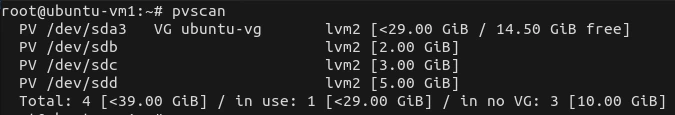

5. Для поиска всех устройств, имеющих отношение к LVM, вводим:

lvmdiskscan

Увеличение томов

Увеличение размера тома может выполняться с помощью добавления еще одного диска или при увеличении имеющихся дисков (например, увеличение диска виртуальной машины). Итак, процедура выполняется в 4 этапа:

1. Расширение физического тома

Расширение физического раздела можно сделать за счет добавление нового диска или увеличение дискового пространства имеющегося (например, если диск виртуальный).

а) Если добавляем еще один диск.

Инициализируем новый диск:

pvcreate /dev/sdd

* в данном примере мы инициализировали диск sdd.

Проверяем объем физического тома:

pvdisplay

б) Если увеличиваем дисковое пространство имеющегося диска.

Увеличиваем размер физического диска командой:

pvresize /dev/sda

* где /dev/sda — диск, который был увеличен.

Проверяем объем физического тома:

pvdisplay

2. Добавление нового диска к группе томов

Независимо от способа увеличения физического тома, расширяем группу томов командой:

vgextend vg01 /dev/sdd

* данная команда расширит группу vg01 за счет добавленого или расширенного диска sdd.

Результат можно увидеть командой:

vgdisplay

3. Увеличение логического раздела

Выполняется одной командой.

а) все свободное пространство:

lvextend -l +100%FREE /dev/vg01/lv01

* данной командой мы выделяем все свободное пространство группы томов vg01 разделу lv01.

б) определенный объем:

lvextend -L+30G /dev/vg01/lv01

* данной командой мы добавляем 30 Гб от группы томов vg01 разделу lv01.

в) до нужного объема:

lvextend -L500G /dev/vg01/lv01

* данной командой мы доводим наш раздел до объема в 500 Гб.

Результат можно увидеть командой:

lvdisplay

Обратить внимание нужно на опцию LV Size:

…

LV Status available

# open 1

LV Size <2,99 GiB

Current LE 765

…

4. Увеличение размера файловой системы

Чтобы сама система увидела больший объем дискового пространства, необходимо увеличить размер файловой системы.

Посмотреть используемую файловую систему:

df -T

Для каждой файловой системы существуют свои инструменты.

ext2/ext3/ext4:

resize2fs /dev/vg01/lv01

XFS:

xfs_growfs /dev/vg01/lv01

Reiserfs:

resize_reiserfs /dev/vg01/lv01

Уменьшение томов

Размер некоторый файловых систем, например, XFS уменьшить нельзя. Из положения можно выйти, создав новый уменьшенный том с переносом на него данных и последующим удалением.

LVM также позволяет уменьшить размер тома. Для этого необходимо выполнить его отмонтирование, поэтому для уменьшения системного раздела безопаснее всего загрузиться с Linux LiveCD. Далее выполняем инструкцию ниже.

Отмонтируем раздел, который нужно уменьшить:

umount /mnt

Выполняем проверку диска:

e2fsck -fy /dev/vg01/lv01

Уменьшаем размер файловой системы:

resize2fs /dev/vg01/lv01 500M

Уменьшаем размер тома:

lvreduce -L-500 /dev/vg01/lv01

На предупреждение системы отвечаем y:

WARNING: Reducing active logical volume to 524,00 MiB.

THIS MAY DESTROY YOUR DATA (filesystem etc.)

Do you really want to reduce vg01/lv01? [y/n]: y

Готово.

Очень важно, чтобы сначала был уменьшен размер файловой системы, затем тома. Также важно не уменьшить размер тома больше, чем файловой системы. В противном случае данные могут быть уничтожены. Перед выполнением операции, обязательно создаем копию важных данных.

Удаление томов

Если необходимо полностью разобрать LVM тома, выполняем следующие действия.

Отмонтируем разделы:

umount /mnt

* где /mnt — точка монтирования для раздела.

Удаляем соответствующую запись из fstab (в противном случае наша система может не загрузиться после перезагрузки):

vi /etc/fstab

#/dev/vg01/lv01 /mnt ext4 defaults 1 2

* в данном примере мы не удалили, а закомментировали строку монтирования диска.

Смотрим информацию о логичеких томах:

lvdisplay

Теперь удаляем логический том:

lvremove /dev/vg01/lv01

На вопрос системы, действительно ли мы хотим удалить логических том, отвечаем да (y):

Do you really want to remove active logical volume vg01/lv01? [y/n]: y

* если система вернет ошибку Logical volume contains a filesystem in use, необходимо убедиться, что мы отмонтировали том.

Смотрим информацию о группах томов:

vgdisplay

Удаляем группу томов:

vgremove vg01

Убираем пометку с дисков на использование их для LVM:

pvremove /dev/sd{b,c,d}

* в данном примере мы деинициализируем диски /dev/sdb, /dev/sdc, /dev/sdd.

В итоге мы получим:

Labels on physical volume «/dev/sdb» successfully wiped.

Labels on physical volume «/dev/sdc» successfully wiped.

Labels on physical volume «/dev/sdd» successfully wiped.

Создание зеркала

С помощью LVM мы может создать зеркальный том — данные, которые мы будем на нем сохранять, будут отправляться на 2 диска. Таким образом, если один из дисков выходит из строя, мы не потеряем свои данные.

Зеркалирование томов выполняется из группы, где есть, минимум, 2 диска.

1. Сначала инициализируем диски:

pvcreate /dev/sd{d,e}

* в данном примере sdd и sde.

2. Создаем группу:

vgcreate vg02 /dev/sd{d,e}

3. Создаем зеркальный том:

lvcreate -L200 -m1 -n lv-mir vg02

* мы создали том lv-mir на 200 Мб из группы vg02.

В итоге:

lsblk

… мы увидим что-то на подобие:

sdd 8:16 0 1G 0 disk

vg02-lv—mir_rmeta_0 253:2 0 4M 0 lvm

vg02-lv—mir 253:6 0 200M 0 lvm

vg02-lv—mir_rimage_0 253:3 0 200M 0 lvm

vg02-lv—mir 253:6 0 200M 0 lvm

sde 8:32 0 1G 0 disk

vg02-lv—mir_rmeta_1 253:4 0 4M 0 lvm

vg02-lv—mir 253:6 0 200M 0 lvm

vg02-lv—mir_rimage_1 253:5 0 200M 0 lvm

vg02-lv—mir 253:6 0 200M 0 lvm

* как видим, на двух дисках у нас появились разделы по 200 Мб.

Работа со снапшотами

Снимки диска позволят нам откатить состояние на определенный момент. Это может послужить быстрым вариантом резервного копирования. Однако нужно понимать, что данные хранятся на одном и том же физическом носителе, а значит, данный способ не является полноценным резервным копированием.

Создание снапшотов для тома, где уже используется файловая система XFS, имеет некоторые нюансы, поэтому разберем разные примеры.

Создание для не XFS:

lvcreate -L500 -s -n sn01 /dev/vg01/lv01

* данная команда помечает, что 500 Мб дискового пространства устройства /dev/vg01/lv01 (тома lv01 группы vg01) будет использоваться для snapshot (опция -s).

Создание для XFS:

xfs_freeze -f /mnt; lvcreate -L500 -s -n sn01 /dev/vg01/lv01; xfs_freeze -u /mnt

* команда xfs_freeze замораживает операции в файловой системе XFS.

Посмотрим список логических томов:

lvs

Получим что-то на подобие:

LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert

lv01 vg01 owi-aos— 1,00g

sn01 vg01 swi-a-s— 500,00m lv01 2,07

* поле Origin показывает, к какому оригинальному логическому тому относится LV, например, в данной ситуации наш раздел для снапшотов относится к lv01.

Также можно посмотреть изменения в томах командой:

lsblk

Мы должны увидеть что-то подобное:

sdc 8:32 0 1G 0 disk

vg01-lv01-real 253:3 0 1G 0 lvm

vg01-lv01 253:2 0 1G 0 lvm /mnt

vg01-sn01 253:5 0 1G 0 lvm

vg01-sn01-cow 253:4 0 500M 0 lvm

vg01-sn01 253:5 0 1G 0 lvm

С этого момента все изменения пишутся в vg01-sn01-cow, а vg01-lv01-real фиксируется только для чтения и мы может откатиться к данному состоянию диска в любой момент.

Содержимое снапшота можно смонтировать и посмотреть, как обычный раздел:

mkdir /tmp/snp

Монтирование не XFS:

mount /dev/vg01/sn01 /tmp/snp

Монтирование XFS:

mount -o nouuid,ro /dev/vg01/sn01 /tmp/snp

Для выполнения отката до снапшота, выполняем команду:

lvconvert —merge /dev/vg01/sn01

Импорт диска из другой системы

Если мы перенесли LVM-диск с другого компьютера или виртуальной машины и хотим подключить его без потери данных, то нужно импортировать том.

Если есть возможность, сначала нужно на старом компьютере отмонтировать том и сделать его экспорт:

umount /mnt

* предположим, что диск примонтирован в /mnt.

Деактивируем группу томов:

vgchange -an vg_test

* в данном примере наша группа называется vg_test.

Делаем экспорт:

vgexport vg_test

После переносим диск на новый компьютер.

На новой системе сканируем группы LVM следующей командой:

pvscan

… система отобразит все LVM-тома (подключенные и нет), например:

PV /dev/sdb VG vg_test lvm2 [1020,00 MiB / 0 free]

PV /dev/sda5 VG ubuntu-vg lvm2 [11,52 GiB / 0 free]

Total: 2 [12,52 GiB] / in use: 2 [12,52 GiB] / in no VG: 0 [0 ]

* в данном примере найдено два диска с томами LVM — /dev/sdb (группа vg_test) и /dev/sda5 (группа ubuntu-vg).

В моем примере новый диск с группой vg_test — будум импортировать его. Вводим команду:

vgimport vg_test

Возможны два варианта ответа:

1) если мы экспортировали том:

Volume group «vg_test» successfully imported

2) если не экспортировали:

Volume group «vg_test» is not exported

Так или иначе, группа томов должна появиться в нашей системе — проверяем командой:

vgdisplay

… мы должны увидеть что-то на подобие:

— Volume group —

VG Name vg_test

System ID

Format lvm2

…

Активируем его:

vgchange -ay vg_test

Готово. Для монтирования раздела, смотрим его командой:

lvdisplay

… и монтируем в нужный каталог, например:

mount /dev/vg_test/lvol0 /mnt

* в данном примере мы примонтируем раздел lvol0 в группе томов vg_test к каталогу /mnt.

Работа с LVM из под Windows

По умолчанию, система Windows не умеет работать с томами LVM. Для реализации такой возможности, необходимо установить утилиту Virtual Volumes.

На данный момент на сайте разработчика имеется предупреждение, что программное обеспечение на тестировании и его не следует применять для разделов, где есть важные данные без резервных копий. В противном случае, данные можно потерять.

Возможные ошибки

Рассмотрим ошибки, с которыми можно столкнуться при работе с LVM.

Device /dev/sdX excluded by a filter

Данную ошибку можно встретить при попытке инициализировать диск командой pvcreate.

Причина: либо диск не полностью чист, либо раздел не имеет нужный тип.

Решение: в зависимости от типа проблемы, рассмотрим 2 варианта.

а) если добавляем целый диск.

Удаляем все метаданные с диска командой:

wipefs -a /dev/sdX

* где вместо X (или sdX) подсталвляем имя диска.

б) если добавляем раздел.

Открываем диск с помощью команды fdisk:

fdisk /dev/sdX

* где вместо X (или sdX) подсталвляем имя диска.

Смотрим список созданных на диске разделов:

: p

Задаем тип раздела:

: t

Выбираем номер раздела (например, раздел номер 3):

: 3

Командой L можно посмотреть список всех типов, но нас интересует конкретный — LVM (8e):

: 8e

Сохраняем настройки:

: w

Материал из Xgu.ru

Перейти к: навигация, поиск

Повесть о Linux и LVM (Logical Volume Manager).

+ дополнения

- Автор: Иван Песин

- Автор: Игорь Чубин (автор дополнений)

В основу этой страницы положена работа «Повесть о Linux и LVM» Ивана Песина, которая, в свою очередь, написана на основе Linux LVM HOWTO.

Она дополнена новыми ссылками и небольшими уточнениями, а также углублённым рассмотрением нескольких дополнительных вопросов.

Один из вопросов это использование kpartx из пакета multipath-tools для построения карты устройства (device map) и рекурсивного доступа к томам LVM (когда LVM развёрнут на разделах, созданных внутри логического тома LVM более низкого уровня). Это может быть полезно при использовании LVM совместно с системами виртуализации.

Второй вопрос — это использование постоянных снимков (persistent snapshot) для быстрого клонирования разделов. Эта возможность может быть полезна как при выполнении резервного копирования, так и при быстром создании виртуальных машин в системах виртуализации (вопрос создания снимков затрагивался и в повести, но здесь он рассмотрен более детально).

Третий вопрос — это сравнение LVM и файловой системой ZFS, набирающей в последнее время большую популярность. На первый взгляд такое сравнение может показаться странным, ведь ZFS — это файловая система, а LVM — система управления томами, то есть нечто, что находится на уровень ниже файловой системы. В действительности, сравнение вполне имеет право на существование, поскольку ZFS это не просто файловая система, а нечто большее. В ней присутствует уровень «storage pool», который берёт на себя те же задачи, что и LVM.

Содержание

- 1 Введение

- 1.1 Терминология

- 1.2 Работа с LVM

- 1.3 Инициализация дисков и разделов

- 1.4 Создание группы томов

- 1.5 Активация группы томов

- 1.6 Удаление группы томов

- 1.7 Добавление физических томов в группу томов

- 1.8 Удаление физических томов из группы томов

- 1.9 Создание логического тома

- 1.10 Удаление логических томов

- 1.11 Увеличение логических томов

- 1.11.1 ext2/ext3/ext4

- 1.11.2 jfs

- 1.11.3 reiserfs

- 1.11.4 xfs

- 1.12 Уменьшение размера логического тома

- 1.12.1 ext2

- 1.12.2 ext2/ext3/ext4

- 1.12.3 reiserfs

- 1.12.4 xfs

- 1.13 Перенос данных с физического тома

- 2 Примеры

- 2.1 Настройка LVM на трех SCSI дисках

- 2.2 Создание логического тома

- 2.3 Создание файловой системы

- 2.4 Тестирование файловой системы

- 2.5 Создание логического тома с «расслоением»

- 2.6 Добавление нового диска

- 2.7 Резервное копирование при помощи «снапшотов»

- 2.8 Удаление диска из группы томов

- 2.9 Перенос группы томов на другую систему

- 2.10 Конвертация корневой файловой системы в LVM

- 2.11 Организация корневой файловой системы в LVM для дистрибутива ALT Master 2.2

- 3 Заключение

- 4 Дополнительные вопросы по LVM

- 4.1 Дисковые разделы и LVM внутри LVM

- 4.2 Создание зашифрованных томов LVM

- 4.3 Сравнение LVM и ZFS

- 4.4 Восстановления LVM после сбоя

- 4.5 Слияние LVM

- 4.6 Thin Provisioning

- 4.7 Поддержка LVM в NetBSD

- 4.8 Работа с LVM в FreeBSD

- 4.9 Работа с LVM в Windows

- 4.10 Альтернативы LVM

- 4.11 Графические инструменты администрирования LVM

- 4.12 Ограничение скорости доступа к LVM-томам

- 5 Приложения

- 5.1 Список команд для работы с LVM

- 6 Дополнительная информация

- 7 Примечания

[править] Введение

Цель статьи — описать процесс установки и использования менеджера логических томов на Linux-системе. LVM (Logical Volume Manager), менеджер логических томов — это система управления дисковым пространством, абстрагирующаяся от физических устройств. Она позволяет эффективно использовать и легко управлять дисковым пространством. LVM обладает хорошей масштабируемостью, уменьшает общую сложность системы. У логических томов, созданных с помощью LVM, можно легко изменить размер, а их названия могут нести большую смысловую нагрузку, в отличие от традиционных /dev/sda, /dev/hda …

Реализации менеджеров логических томов существуют практически во всех UNIX-подобных операционных системах. Зачастую они сильно отличаются в реализации, но все они основаны на одинаковой идее и преследуют аналогичные цели. Одна из основных реализаций была выполнена Open Software Foundation (OSF) и сейчас входит в состав многих систем, например IBM AIX, DEC Tru64, HP/UX. Она же послужила и основой для Linux-реализации LVM.

Данная статья является переработкой и дополнением LVM-HOWTO.

[править] Терминология

Поскольку система управления логическими томами использует собственную модель представления дискового пространства, нам необходимо определиться с терминами и взаимосвязями понятий. Рассмотрим схему, основанную на диаграмме Эрика Бегфорса (Erik Bеgfors), приведенную им в списке рассылки linux-lvm. Она демонстрирует взаимосвязь понятий системы LVM:

sda1 sda2 sdb sdc <-- PV

| | | |

| | | |

+--------+- VG00 -+-------+ <-- VG

|

+-------+-------+---------+

| | | |

root usr home var <-- LV

| | | |

ext3 reiserfs reiserfs xfs <-- Файловые системы

Обозначения и понятия:

- PV, Physical volume, физический том. Обычно это раздел на диске или весь диск. В том числе, устройства программного и аппаратного RAID (которые уже могут включать в себя несколько физических дисков). Физические тома входят в состав группы томов.

- VG, Volume group, группа томов. Это самый верхний уровень абстрактной модели, используемой системой LVM. С одной стороны группа томов состоит из физических томов, с другой — из логических и представляет собой единую административную единицу.

- LV, Logical volume, логический том. Раздел группы томов, эквивалентен разделу диска в не-LVM системе. Представляет собой блочное устройство и, как следствие, может содержать файловую систему.

- PE, Physical extent, физический экстент. Каждый физический том делится на порции данных, называющиеся физическими экстентами. Их размеры те же, что и у логических экстентов.

- LE, Logical extent, логический экстент. Каждый логический том делится на порции данных, называющиеся логическими экстентами. Размер логических экстентов не меняется в пределах группы томов.

Давайте теперь соединим все эти понятия в общую картину. Пусть у нас имеется группа томов VG00 с размером физического экстента 4Мб. В эту группу мы добавляем два раздела, /dev/hda1 и /dev/hdb1. Эти разделы становятся физическими томами, например PV1 и PV2 (символьные имена присваивает администратор, так что они могут быть более осмысленными). Физические тома делятся на 4-х мегабайтные порции данных, т.к. это размер физического экстента. Диски имеют разный размер: PV1 получается размером в 99 экстентов, а PV2 — размером в 248 экстентов. Теперь можно приступать к созданию логических томов, размером от 1 до 347 (248+99) экстентов. При создании логического тома, определяется отображение между логическими и физическими экстентами. Например, логический экстент 1 может отображаться в физический экстент 51 тома PV1. В этом случае, данные, записанные в первые 4Мб логического экстента 1, будут в действительности записаны в 51-й экстент тома PV1.

Администратор может выбрать алгоритм отображения логических экстентов в физические. На данный момент доступны два алгоритма:

1. Линейное отображение последовательно назначает набор физических экстентов области логического тома, т.е. LE 1 — 99 отображаются на PV1, а LE 100 — 347 — на PV2.

2. «Расслоенное» (striped) отображение разделяет порции данных логических экстентов на определенное количество физических томов. То есть:

1-я порция данных LE[1] -> PV1[1],

2-я порция данных LE[1] -> PV2[1],

3-я порция данных LE[1] -> PV3[1],

4-я порция данных LE[1] -> PV1[2], и т.д.

Похожая схема используется в работе RAID нулевого уровня. В некоторых ситуациях этот алгоритм отображения позволяет увеличить производительность логического тома. Однако он имеет значительное ограничение: логический том с данным отображением не может быть расширен за пределы физических томов, на которых он изначально и создавался.

Великолепная возможность, предоставляемая системой LVM — это «снапшоты». Они позволяют администратору создавать новые блочные устройства с точной копией логического тома, «замороженного» в какой-то момент времени. Обычно это используется в пакетных режимах. Например, при создании резервной копии системы. Однако при этом вам не будет нужно останавливать работающие задачи, меняющие данные на файловой системе. Когда необходимые процедуры будут выполнены, системный администратор может просто удалить устройство-«снапшот». Ниже мы рассмотрим работу с таким устройством.

[править] Работа с LVM

Давайте теперь рассмотрим задачи, стоящие перед администратором LVM системы. Помните, что для работы с системой LVM ее нужно инициализировать командами:

%# vgscan %# vgchange -ay

Первая команда сканирует диски на предмет наличия групп томов, вторая активирует все найденные группы томов. Аналогично для завершения всех работ, связанных с LVM, нужно выполнить деактивацию групп:

%# vgchange -an

Первые две строки нужно будет поместить в скрипты автозагрузки (если их там нет), а последнюю можно дописать в скрипт shutdown.

[править] Инициализация дисков и разделов

Перед использованием диска или раздела в качестве физического тома необходимо его инициализировать:

Для целого диска:

%# pvcreate /dev/hdb

Эта команда создает в начале диска дескриптор группы томов.

Если вы получили ошибку инициализации диска с таблицей разделов — проверьте, что работаете именно с нужным диском, и когда полностью будете уверены в том, что делаете, выполните следующие команды

%# dd if=/dev/zero of=/dev/diskname bs=1k count=1 %# blockdev --rereadpt /dev/diskname

Эти команды уничтожат таблицу разделов на целевом диске.

Для разделов:

Установите программой fdisk тип раздела в 0x8e.

%# pvcreate /dev/hdb1

Команда создаст в начале раздела /dev/hdb1 дескриптор группы томов.

[править] Создание группы томов

Для создания группы томов используется команда ‘vgcreate’

%# vgcreate vg00 /dev/hda1 /dev/hdb1

|

|

Если вы используете devfs важно указывать полное имя в devfs, а не ссылку в каталоге /dev. Таким образом приведенная команда должна выглядеть в системе с devfs так: # vgcreate vg00 /dev/ide/host0/bus0/target0/lun0/part1 /dev/ide/host0/bus0/target1/lun0/part1 |

Кроме того, вы можете задать размер экстента при помощи ключа «-s», если значение по умолчанию в 4Мб вас не устраивает. Можно, также, указать ограничения возможного количества физических и логических томов.

[править] Активация группы томов

После перезагрузки системы или выполнения команды vgchange -an, ваши группы томов и логические тома находятся в неактивном состоянии. Для их активации необходимо выполнить команду

%# vgchange -a y vg00

[править] Удаление группы томов

Убедитесь, что группа томов не содержит логических томов. Как это сделать, показано в следующих разделах.

Деактивируйте группу томов:

%# vgchange -a n vg00

Теперь можно удалить группу томов командой:

%# vgremove vg00

[править] Добавление физических томов в группу томов

Для добавления предварительно инициализированного физического тома в существующую группу томов используется команда ‘vgextend’:

%# vgextend vg00 /dev/hdc1

^^^^^^^^^ новый физический том

[править] Удаление физических томов из группы томов

Убедитесь, что физический том не используется никакими логическими томами. Для этого используйте команду ‘pvdisplay’:

%# pvdisplay /dev/hda1 --- Physical volume --- PV Name /dev/hda1 VG Name vg00 PV Size 1.95 GB / NOT usable 4 MB [LVM: 122 KB] PV# 1 PV Status available Allocatable yes (but full) Cur LV 1 PE Size (KByte) 4096 Total PE 499 Free PE 0 Allocated PE 499 PV UUID Sd44tK-9IRw-SrMC-MOkn-76iP-iftz-OVSen7

Если же физический том используется, вам нужно будет перенести данные на другой физический том при помощи команды pvmove.

%# pvmove /dev/hda1

Затем можно использовать ‘vgreduce’ для удаления физических томов:

%# vgreduce vg00 /dev/hda1

После этого используя pvremove можно удалить устройство, в котором больше нет необходимости, заполняя его метаданные нулями.

Эта процедура будет описана в следующих разделах.

[править] Создание логического тома

Для того, чтобы создать логический том «lv00», размером 1500Мб, выполните команду:

%# lvcreate -L1500 -n lv00 vg00

Без указания суффикса размеру раздела используется множитель «мегабайт» (в системе СИ равный 106 байт), что и продемонстрировано в примере выше. Суффиксы в верхнем регистре (KMGTPE) соответствуют единицам в системе СИ (с основанием 10), например, G — гигабайт равен 109 байт, а суффиксы в нижнем регистре (kmgtpe) соответствуют единицам в системе IEC (с основанием 2), например g — гибибайт равен 230 байт.

Для создания логического тома размером в 100 логических экстентов с расслоением по двум физическим томам и размером блока данных 4 KB:

%# lvcreate -i2 -I4 -l100 -n lv01 vg00

Если вы хотите создать логический том, полностью занимающий группу томов, выполните команду vgdisplay, чтобы узнать полный размер группы томов, после чего используйте команду lvcreate.

%# vgdisplay vg00 | grep "Total PE" Total PE 10230 %# lvcreate -l 10230 vg00 -n lv02

Эти команды создают логический том lv02, полностью заполняющий группу томов.

Тоже самое можно реализовать командой

%# lvcreate -l100%FREE vg00 -n lv02

[править] Удаление логических томов

Логический том должен быть размонтирован перед удалением:

%# umount /dev/vg00/home %# lvremove /dev/vg00/home lvremove -- do you really want to remove "/dev/vg00/home"? [y/n]: y lvremove -- doing automatic backup of volume group "vg00" lvremove -- logical volume "/dev/vg00/home" successfully removed

[править] Увеличение логических томов

Для увеличения логического тома вам нужно просто указать команде lvextend до какого размера вы хотите увеличить том:

%# lvextend -L12G /dev/vg00/home lvextend -- extending logical volume "/dev/vg00/home" to 12 GB lvextend -- doing automatic backup of volume group "vg00" lvextend -- logical volume "/dev/vg00/home" successfully extended

В результате /dev/vg00/home увеличится до 12Гбайт.

%# lvextend -L+1G /dev/vg00/home lvextend -- extending logical volume "/dev/vg00/home" to 13 GB lvextend -- doing automatic backup of volume group "vg00" lvextend -- logical volume "/dev/vg00/home" successfully extended

Эта команда увеличивает размер логического тома на 1Гб.

%# lvextend -l +100%FREE /dev/vg00/home lvextend -- extending logical volume "/dev/vg00/home" to 68.59 GB lvextend -- doing automatic backup of volume group "vg00" lvextend -- logical volume "/dev/vg00/home" successfully extended

А эта команда увеличивает размер логического тома до максимально доступного.

После того как вы увеличили логический том, необходимо соответственно увеличить размер файловой системы. Как это сделать зависит от типа используемой файловой системы.

По умолчанию большинство утилит изменения размера файловой системы увеличивают ее размер до размера соответствующего логического тома. Так что вам не нужно беспокоится об указании одинаковых размеров для всех команд.

[править] ext2/ext3/ext4

Если вы не пропатчили ваше ядро патчем ext2online, вам будет необходимо размонтировать файловую систему перед изменением размера:

%# umount /dev/vg00/home %# resize2fs /dev/vg00/home %# mount /dev/vg00/home /home

Если у вас нет пакета e2fsprogs 1.19 его можно загрузить с сайта ext2resize.sourceforge.net.

Для файловой системы ext2 есть и другой путь. В состав LVM входит утилита e2fsadm, которая выполняет и lvextend, и resize2fs (она также выполняет и уменьшение размера файловой системы, это описано в следующем разделе). Так что можно использовать одну команду:

%# e2fsadm -L+1G /dev/vg00/home

что эквивалентно двум следующим:

%# lvextend -L+1G /dev/vg00/home %# resize2fs /dev/vg00/home

|

|

вам все равно нужно будет размонтировать файловую систему перед выполнением e2fsadm. |

[править] jfs

mount -o remount,resize /home

[править] reiserfs

Увеличивать размер файловых систем Reiserfs можно как в смонтированном, так и в размонтированном состоянии.

Увеличить размер смонтированной файловой системы:

%# resize_reiserfs -f /dev/vg00/home

Увеличить размер размонтированной файловой системы:

%# umount /dev/vg00/homevol %# resize_reiserfs /dev/vg00/homevol %# mount -treiserfs /dev/vg00/homevol /home

[править] xfs

Размер файловой системы XFS можно увеличить только в смонтированном состоянии. Кроме того, утилите в качестве параметра нужно передать точку монтирования, а не имя устройства:

%# xfs_growfs /home

[править] Уменьшение размера логического тома

Логические тома могут быть уменьшены в размере, точно также как и увеличены. Однако очень важно помнить, что нужно в первую очередь уменьшить размер файловой системы, и только после этого уменьшать размер логического тома. Если вы нарушите последовательность, вы можете потерять данные.

[править] ext2

При использовании файловой системы ext2, как уже указывалось ранее, можно использовать команду e2fsadm:

# umount /home # e2fsadm -L-1G /dev/vg00/home # mount /home

Если вы хотите выполнить операцию по уменьшению логического тома вручную, вам нужно знать размер тома в блоках:

# umount /home # resize2fs /dev/vg00/home 524288 # lvreduce -L-1G /dev/vg00/home # mount /home

[править] ext2/ext3/ext4

Способ применимый в более современных системах.

$ sudo umount /home $ sudo e2fsck -f /dev/vg00/home $ sudo resize2fs /dev/vg00/home 11G

Указываем размер явно и с некоторым с запасом:

$ sudo lvreduce -L 12G /dev/vg00/home $ sudo e2fsck -f /dev/vg00/home $ sudo mount /home

[править] reiserfs

При уменьшении размера файловой системы Reiserfs, ее нужно размонтировать:

# umount /home # resize_reiserfs -s-1G /dev/vg00/home # lvreduce -L-1G /dev/vg00/home # mount -treiserfs /dev/vg00/home /home

[править] xfs

Уменьшить размер файловой системы XFS нельзя.

Примечание: обратите внимание на то, что для уменьшения размера файловых систем, необходимо их размонтировать. Это вносит определенные трудности, если вы желаете уменьшить размер корневой файловой системы. В этом случае можно применить следующий метод: загрузится с CD дистрибутива, поддерживающего LVM. Перейти в командный режим (обычно это делается нажатием клавиш Alt+F2) и выполнить команды сканирования и активации группы томов:

%# vgscan %# vgchange -a y

Теперь вы имеете доступ к логическим томам и можете изменять их размеры:

%# resize_reiserfs -s-500M /dev/vg00/root %# lvreduce -L-500M /dev/vg00/root %# reboot

[править] Перенос данных с физического тома

Для того, чтобы можно было удалить физический том из группы томов, необходимо освободить все занятые на нем физические экстенты. Это делается путем перераспределения занятых физических экстентов на другие физические тома. Следовательно, в группе томов должно быть достаточно свободных физических экстентов. Описание операции удаления физического тома приведено в разделе примеров.

[править] Примеры

[править] Настройка LVM на трех SCSI дисках

В первом примере мы настроим логический том из трех SCSI дисков. Устройства дисков: /dev/sda, /dev/sdb и /dev/sdc.

Перед добавлением в группу томов диски нужно инициализировать:

%# pvcreate /dev/sda %# pvcreate /dev/sdb %# pvcreate /dev/sdc

После выполнения этих команд в начале каждого диска создастся область дескрипторов группы томов.

Теперь создадим группу томов vg01, состоящую из этих дисков:

%# vgcreate vg01 /dev/sda /dev/sdb /dev/sdc

Проверим статус группы томов командой vgdisplay:

%# vgdisplay --- Volume Group --- VG Name vg01 VG Access read/write VG Status available/resizable VG # 1 MAX LV 256 Cur LV 0 Open LV 0 MAX LV Size 255.99 GB Max PV 256 Cur PV 3 Act PV 3 VG Size 1.45 GB PE Size 4 MB Total PE 372 Alloc PE / Size 0 / 0 Free PE / Size 372/ 1.45 GB VG UUID nP2PY5-5TOS-hLx0-FDu0-2a6N-f37x-0BME0Y

Обратите внимание на первые три строки и строку с общим размером группы томов. Она должна соответствовать сумме всех трех дисков. Если всё в порядке, можно переходить к следующей задаче.

[править] Создание логического тома

После успешного создания группы томов, можно начать создавать логические тома в этой группе. Размер тома может быть любым, но, естественно, не более всего размера группы томов. В этом примере мы создадим один логический том размером 1 Гб. Мы не будем использовать «расслоение», поскольку при этом невозможно добавить диск в группу томов после создания логического тома, использующего данный алгоритм.

%# lvcreate -L1G -nusrlv vg01 lvcreate -- doing automatic backup of "vg01" lvcreate -- logical volume "/dev/vg01/usrlv" successfully created

[править] Создание файловой системы

Создадим на логическом томе файловую систему ext2:

%# mke2fs /dev/vg01/usrlv mke2fs 1.19, 13-Jul-2000 for EXT2 FS 0.5b, 95/08/09 Filesystem label= OS type: Linux Block size=4096 (log=2) Fragment size=4096 (log=2) 131072 inodes, 262144 blocks 13107 blocks (5.00%) reserved for the super user First data block=0 9 block groups 32768 blocks per group, 32768 fragments per group 16384 inodes per group Superblock backups stored on blocks: 32768, 98304, 163840, 229376 Writing inode tables: done Writing superblocks and filesystem accounting information: done

[править] Тестирование файловой системы

Смонтируйте логический том и проверьте все ли в порядке:

%# mount /dev/vg01/usrlv /mnt %# df Filesystem 1k-blocks Used Available Use% Mounted on /dev/hda1 1311552 628824 616104 51% / /dev/vg01/usrlv 1040132 20 987276 0% /mnt

Если вы все сделали правильно, у вас должен появиться логический том с файловой системой ext2, смонтированный в точке /mnt.

[править] Создание логического тома с «расслоением»

Рассмотрим теперь вариант логического тома, использующего алгоритм «расслоения». Как уже указывалось выше, минусом этого решения является невозможность добавления дополнительного диска.

Процедура создания данного типа логического тома также требует инициализации устройств и добавления их в группу томов, как это уже было показано.

Для создания логического тома с «расслоением» на три физических тома с блоком данных 4Кб выполните команду:

%# lvcreate -i3 -I4 -L1G -nvarlv vg01 lvcreate -- rounding 1048576 KB to stripe boundary size 1056768 KB / 258 PE lvcreate -- doing automatic backup of "vg01" lvcreate -- logical volume "/dev/vg01/varlv" successfully created

После чего можно создавать файловую систему на логическом томе.

[править] Добавление нового диска

Рассмотрим систему со следующей конфигурацией: