|

|

This article’s factual accuracy may be compromised due to out-of-date information. Please help update this article to reflect recent events or newly available information. (March 2017) |

Single instruction, multiple data

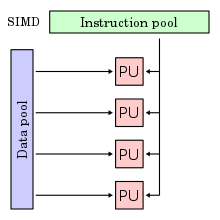

Single instruction, multiple data (SIMD) is a type of parallel processing in Flynn’s taxonomy. SIMD can be internal (part of the hardware design) and it can be directly accessible through an instruction set architecture (ISA), but it should not be confused with an ISA. SIMD describes computers with multiple processing elements that perform the same operation on multiple data points simultaneously.

Such machines exploit data level parallelism, but not concurrency: there are simultaneous (parallel) computations, but each unit performs the exact same instruction at any given moment (just with different data). SIMD is particularly applicable to common tasks such as adjusting the contrast in a digital image or adjusting the volume of digital audio. Most modern CPU designs include SIMD instructions to improve the performance of multimedia use. SIMD has three different subcategories in Flynn’s 1972 Taxonomy, one of which is SIMT. SIMT should not be confused with software threads or hardware threads, both of which are task time-sharing (time-slicing). SIMT is true simultaneous parallel hardware-level execution.

History[edit]

The first use of SIMD instructions was in the ILLIAC IV, which was completed in 1966.

SIMD was the basis for vector supercomputers of the early 1970s such as the CDC Star-100 and the Texas Instruments ASC, which could operate on a «vector» of data with a single instruction. Vector processing was especially popularized by Cray in the 1970s and 1980s. Vector processing architectures are now considered separate from SIMD computers: Duncan’s Taxonomy includes them where Flynn’s Taxonomy does not, due to Flynn’s work (1966, 1972) pre-dating the Cray-1 (1977).

The first era of modern SIMD computers was characterized by massively parallel processing-style supercomputers such as the Thinking Machines CM-1 and CM-2. These computers had many limited-functionality processors that would work in parallel. For example, each of 65,536 single-bit processors in a Thinking Machines CM-2 would execute the same instruction at the same time, allowing, for instance, to logically combine 65,536 pairs of bits at a time, using a hypercube-connected network or processor-dedicated RAM to find its operands. Supercomputing moved away from the SIMD approach when inexpensive scalar MIMD approaches based on commodity processors such as the Intel i860 XP[2] became more powerful, and interest in SIMD waned.

The current era of SIMD processors grew out of the desktop-computer market rather than the supercomputer market. As desktop processors became powerful enough to support real-time gaming and audio/video processing during the 1990s, demand grew for this particular type of computing power, and microprocessor vendors turned to SIMD to meet the demand.[3] Hewlett-Packard introduced MAX instructions into PA-RISC 1.1 desktops in 1994 to accelerate MPEG decoding.[4] Sun Microsystems introduced SIMD integer instructions in its «VIS» instruction set extensions in 1995, in its UltraSPARC I microprocessor. MIPS followed suit with their similar MDMX system.

The first widely deployed desktop SIMD was with Intel’s MMX extensions to the x86 architecture in 1996. This sparked the introduction of the much more powerful AltiVec system in the Motorola PowerPC and IBM’s POWER systems. Intel responded in 1999 by introducing the all-new SSE system. Since then, there have been several extensions to the SIMD instruction sets for both architectures. Advanced vector extensions AVX, AVX2 and AVX-512 are developed by Intel. AMD supports AVX and AVX2 in their current products.

All of these developments have been oriented toward support for real-time graphics, and are therefore oriented toward processing in two, three, or four dimensions, usually with vector lengths of between two and sixteen words, depending on data type and architecture. When new SIMD architectures need to be distinguished from older ones, the newer architectures are then considered «short-vector» architectures, as earlier SIMD and vector supercomputers had vector lengths from 64 to 64,000. A modern supercomputer is almost always a cluster of MIMD computers, each of which implements (short-vector) SIMD instructions.

Advantages[edit]

An application that may take advantage of SIMD is one where the same value is being added to (or subtracted from) a large number of data points, a common operation in many multimedia applications. One example would be changing the brightness of an image. Each pixel of an image consists of three values for the brightness of the red (R), green (G) and blue (B) portions of the color. To change the brightness, the R, G and B values are read from memory, a value is added to (or subtracted from) them, and the resulting values are written back out to memory. Audio DSPs would likewise, for volume control, multiply both Left and Right channels simultaneously.

With a SIMD processor there are two improvements to this process. For one the data is understood to be in blocks, and a number of values can be loaded all at once. Instead of a series of instructions saying «retrieve this pixel, now retrieve the next pixel», a SIMD processor will have a single instruction that effectively says «retrieve n pixels» (where n is a number that varies from design to design). For a variety of reasons, this can take much less time than retrieving each pixel individually, as with a traditional CPU design.

Another advantage is that the instruction operates on all loaded data in a single operation. In other words, if the SIMD system works by loading up eight data points at once, the add operation being applied to the data will happen to all eight values at the same time. This parallelism is separate from the parallelism provided by a superscalar processor; the eight values are processed in parallel even on a non-superscalar processor, and a superscalar processor may be able to perform multiple SIMD operations in parallel.

Disadvantages[edit]

- Not all algorithms can be vectorized easily. For example, a flow-control-heavy task like code parsing may not easily benefit from SIMD; however, it is theoretically possible to vectorize comparisons and «batch flow» to target maximal cache optimality, though this technique will require more intermediate state. Note: Batch-pipeline systems (example: GPUs or software rasterization pipelines) are most advantageous for cache control when implemented with SIMD intrinsics, but they are not exclusive to SIMD features. Further complexity may be apparent to avoid dependence within series such as code strings; while independence is required for vectorization.[clarification needed]

- Large register files which increases power consumption and required chip area.

- Currently, implementing an algorithm with SIMD instructions usually requires human labor; most compilers don’t generate SIMD instructions from a typical C program, for instance. Automatic vectorization in compilers is an active area of computer science research. (Compare vector processing.)

- Programming with particular SIMD instruction sets can involve numerous low-level challenges.

- SIMD may have restrictions on data alignment; programmers familiar with one particular architecture may not expect this. Worse: the alignment may change from one revision or «compatible» processor to another.

- Gathering data into SIMD registers and scattering it to the correct destination locations is tricky (sometimes requiring permute operations) and can be inefficient.

- Specific instructions like rotations or three-operand addition are not available in some SIMD instruction sets.

- Instruction sets are architecture-specific: some processors lack SIMD instructions entirely, so programmers must provide non-vectorized implementations (or different vectorized implementations) for them.

- Different architectures provide different register sizes (e.g. 64, 128, 256 and 512 bits) and instruction sets, meaning that programmers must provide multiple implementations of vectorized code to operate optimally on any given CPU. In addition, the possible set of SIMD instructions grows with each new register size. Unfortunately, for legacy support reasons, the older versions cannot be retired.

- The early MMX instruction set shared a register file with the floating-point stack, which caused inefficiencies when mixing floating-point and MMX code. However, SSE2 corrects this.

To remedy problems 1 and 5, RISC-V’s vector extension uses an alternative approach: instead of exposing the sub-register-level details to the programmer, the instruction set abstracts them out as a few «vector registers» that use the same interfaces across all CPUs with this instruction set. The hardware handles all alignment issues and «strip-mining» of loops. Machines with different vector sizes would be able to run the same code. LLVM calls this vector type «vscale».[citation needed]

An order of magnitude increase in code size is not uncommon, when compared to equivalent scalar or equivalent vector code, and an order of magnitude or greater effectiveness (work done per instruction) is achievable with Vector ISAs.[5]

ARM’s Scalable Vector Extension takes another approach, known in Flynn’s Taxonomy as «Associative Processing», more commonly known today as «Predicated» (masked) SIMD. This approach is not as compact as Vector processing but is still far better than non-predicated SIMD. Detailed comparative examples are given in the Vector processing page.

Chronology[edit]

| Year | Example |

|---|---|

| 1974 | ILLIAC IV |

| 1974 | ICL Distributed Array Processor (DAP) |

| 1976 | Burroughs Scientific Processor |

| 1981 | Geometric-Arithmetic Parallel Processor from Martin Marietta (continued at Lockheed Martin, then at Teranex and Silicon Optix) |

| 1983-1991 | Massively Parallel Processor (MPP), from NASA/Goddard Space Flight Center |

| 1985 | Connection Machine, models 1 and 2 (CM-1 and CM-2), from Thinking Machines Corporation |

| 1987-1996 | MasPar MP-1 and MP-2 |

| 1991 | Zephyr DC from Wavetracer |

| 2001 | Xplor from Pyxsys, Inc. |

Hardware[edit]

Small-scale (64 or 128 bits) SIMD became popular on general-purpose CPUs in the early 1990s and continued through 1997 and later with Motion Video Instructions (MVI) for Alpha. SIMD instructions can be found, to one degree or another, on most CPUs, including IBM’s AltiVec and SPE for PowerPC, HP’s PA-RISC Multimedia Acceleration eXtensions (MAX), Intel’s MMX and iwMMXt, SSE, SSE2, SSE3 SSSE3 and SSE4.x, AMD’s 3DNow!, ARC’s ARC Video subsystem, SPARC’s VIS and VIS2, Sun’s MAJC, ARM’s Neon technology, MIPS’ MDMX (MaDMaX) and MIPS-3D. The IBM, Sony, Toshiba co-developed Cell Processor’s SPU’s instruction set is heavily SIMD based. Philips, now NXP, developed several SIMD processors named Xetal. The Xetal has 320 16-bit processor elements especially designed for vision tasks.

Modern graphics processing units (GPUs) are often wide SIMD implementations, capable of branches, loads, and stores on 128 or 256 bits at a time.

Intel’s AVX-512 SIMD instructions process 512 bits of data at once.

Software[edit]

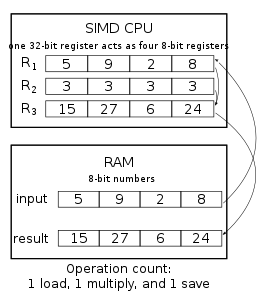

The ordinary tripling of four 8-bit numbers. The CPU loads one 8-bit number into R1, multiplies it with R2, and then saves the answer from R3 back to RAM. This process is repeated for each number.

The SIMD tripling of four 8-bit numbers. The CPU loads 4 numbers at once, multiplies them all in one SIMD-multiplication, and saves them all at once back to RAM. In theory, the speed can be multiplied by 4.

SIMD instructions are widely used to process 3D graphics, although modern graphics cards with embedded SIMD have largely taken over this task from the CPU. Some systems also include permute functions that re-pack elements inside vectors, making them particularly useful for data processing and compression. They are also used in cryptography.[6][7][8] The trend of general-purpose computing on GPUs (GPGPU) may lead to wider use of SIMD in the future.

Adoption of SIMD systems in personal computer software was at first slow, due to a number of problems. One was that many of the early SIMD instruction sets tended to slow overall performance of the system due to the re-use of existing floating point registers. Other systems, like MMX and 3DNow!, offered support for data types that were not interesting to a wide audience and had expensive context switching instructions to switch between using the FPU and MMX registers. Compilers also often lacked support, requiring programmers to resort to assembly language coding.

SIMD on x86 had a slow start. The introduction of 3DNow! by AMD and SSE by Intel confused matters somewhat, but today the system seems to have settled down (after AMD adopted SSE) and newer compilers should result in more SIMD-enabled software. Intel and AMD now both provide optimized math libraries that use SIMD instructions, and open source alternatives like libSIMD, SIMDx86 and SLEEF have started to appear (see also libm).[9]

Apple Computer had somewhat more success, even though they entered the SIMD market later than the rest. AltiVec offered a rich system and can be programmed using increasingly sophisticated compilers from Motorola, IBM and GNU, therefore assembly language programming is rarely needed. Additionally, many of the systems that would benefit from SIMD were supplied by Apple itself, for example iTunes and QuickTime. However, in 2006, Apple computers moved to Intel x86 processors. Apple’s APIs and development tools (XCode) were modified to support SSE2 and SSE3 as well as AltiVec. Apple was the dominant purchaser of PowerPC chips from IBM and Freescale Semiconductor and even though they abandoned the platform, further development of AltiVec is continued in several PowerPC and Power ISA designs from Freescale and IBM.

SIMD within a register, or SWAR, is a range of techniques and tricks used for performing SIMD in general-purpose registers on hardware that doesn’t provide any direct support for SIMD instructions. This can be used to exploit parallelism in certain algorithms even on hardware that does not support SIMD directly.

Programmer interface[edit]

It is common for publishers of the SIMD instruction sets to make their own C/C++ language extensions with intrinsic functions or special datatypes (with operator overloading) guaranteeing the generation of vector code. Intel, AltiVec, and ARM NEON provide extensions widely adopted by the compilers targeting their CPUs. (More complex operations are the task of vector math libraries.)

The GNU C Compiler takes the extensions a step further by abstracting them into a universal interface that can be used on any platform by providing a way of defining SIMD datatypes.[10] The LLVM Clang compiler also implements the feature, with an analogous interface defined in the IR.[11] Rust’s packed_simd crate uses this interface, and so does Swift 2.0+.

C++ has an experimental interface std::experimental::simd that works similarly to the GCC extension. LLVM’s libcxx seems to implement it.[citation needed] For GCC and libstdc++, a wrapper library that builds on top of the GCC extension is available.[12]

Microsoft added SIMD to .NET in RyuJIT.[13] The System.Numerics.Vector package, available on NuGet, implement SIMD datatypes.[14] Java also has a new proposed API for SIMD instructions [15] available in OpenJDK 17 in an incubator module. It also has a safe fallback mechanism on unsupported CPUs to simple loops.

Instead of providing an SIMD datatype, compilers can also be hinted to auto-vectorize some loops, potentially taking some assertions about the lack of data dependency. This is not as flexible as manipulating SIMD variables directly, but is easier to use. OpenMP 4.0+ has a #pragma omp simd hint.[16] This OpenMP interface has replaced a wide set of nonstandard extensions, including Cilk’s #pragma simd.,[17] GCC’s #pragma GCC ivdep, and many more.[18]

SIMD multi-versioning[edit]

Consumer software is typically expected to work on a range of CPUs covering multiple generations, which could limit the programmer’s ability to use new SIMD instructions to improve the computational performance of a program. The solution is to include multiple versions of the same code that uses either older or newer SIMD technologies, and pick one that best fits the user’s CPU at run-time (dynamic dispatch). There are two main camps of solutions:

- Function multi-versioning (FMV): a subroutine in the program or a library is duplicated and compiled for many instruction set extensions, and the program decides which one to use at run-time.

- Library multi-versioning (LMV): the entire programming library is duplicated for many instruction set extensions, and the operating system or the program decides which one to load at run-time.

FMV, manually coded in assembly language, is quite commonly used in a number of performance-critical libraries such as glibc and libjpeg-turbo. Intel C++ Compiler, GNU Compiler Collection since GCC 6, and Clang since clang 7 allow for a simplified approach, with the compiler taking care of function duplication and selection. GCC and clang requires explicit target_clones labels in the code to «clone» functions,[19] while ICC does so automatically (under the command-line option /Qax). The Rust programming language also supports FMV. The setup is similar to GCC and Clang in that the code defines what instruction sets to compile for, but cloning is manually done via inlining.[20]

As using FMV requires code modification on GCC and Clang, vendors more commonly use library multi-versioning: this is easier to achieve as only compiler switches need to be changed. Glibc supports LMV and this functionality is adopted by the Intel-backed Clear Linux project.[21]

SIMD on the web[edit]

In 2013 John McCutchan announced that he had created a high-performance interface to SIMD instruction sets for the Dart programming language, bringing the benefits of SIMD to web programs for the first time. The interface consists of two types:[22]

- Float32x4, 4 single precision floating point values.

- Int32x4, 4 32-bit integer values.

Instances of these types are immutable and in optimized code are mapped directly to SIMD registers. Operations expressed in Dart typically are compiled into a single instruction without any overhead. This is similar to C and C++ intrinsics. Benchmarks for 4×4 matrix multiplication, 3D vertex transformation, and Mandelbrot set visualization show near 400% speedup compared to scalar code written in Dart.

McCutchan’s work on Dart, now called SIMD.js, has been adopted by ECMAScript and Intel announced at IDF 2013 that they are implementing McCutchan’s specification for both V8 and SpiderMonkey.[23] However, by 2017, SIMD.js has been taken out of the ECMAScript standard queue in favor of pursuing a similar interface in WebAssembly.[24] As of August 2020, the WebAssembly interface remains unfinished, but its portable 128-bit SIMD feature has already seen some use in many engines.

Emscripten, Mozilla’s C/C++-to-JavaScript compiler, with extensions can enable compilation of C++ programs that make use of SIMD intrinsics or GCC-style vector code to the SIMD API of JavaScript, resulting in equivalent speedups compared to scalar code.[25] It also supports (and now prefers) the WebAssembly 128-bit SIMD proposal.[26]

Commercial applications[edit]

Though it has generally proven difficult to find sustainable commercial applications for SIMD-only processors, one that has had some measure of success is the GAPP, which was developed by Lockheed Martin and taken to the commercial sector by their spin-off Teranex. The GAPP’s recent incarnations have become a powerful tool in real-time video processing applications like conversion between various video standards and frame rates (NTSC to/from PAL, NTSC to/from HDTV formats, etc.), deinterlacing, image noise reduction, adaptive video compression, and image enhancement.

A more ubiquitous application for SIMD is found in video games: nearly every modern video game console since 1998 has incorporated a SIMD processor somewhere in its architecture. The PlayStation 2 was unusual in that one of its vector-float units could function as an autonomous DSP executing its own instruction stream, or as a coprocessor driven by ordinary CPU instructions. 3D graphics applications tend to lend themselves well to SIMD processing as they rely heavily on operations with 4-dimensional vectors. Microsoft’s Direct3D 9.0 now chooses at runtime processor-specific implementations of its own math operations, including the use of SIMD-capable instructions.

One of the recent processors to use vector processing is the Cell Processor developed by IBM in cooperation with Toshiba and Sony. It uses a number of SIMD processors (a NUMA architecture, each with independent local store and controlled by a general purpose CPU) and is geared towards the huge datasets required by 3D and video processing applications. It differs from traditional ISAs by being SIMD from the ground up with no separate scalar registers.

Ziilabs produced an SIMD type processor for use on mobile devices, such as media players and mobile phones.[27]

Larger scale commercial SIMD processors are available from ClearSpeed Technology, Ltd. and Stream Processors, Inc. ClearSpeed’s CSX600 (2004) has 96 cores each with two double-precision floating point units while the CSX700 (2008) has 192. Stream Processors is headed by computer architect Bill Dally. Their Storm-1 processor (2007) contains 80 SIMD cores controlled by a MIPS CPU.

See also[edit]

- Streaming SIMD Extensions, MMX, SSE2, SSE3, Advanced Vector Extensions, AVX-512

- Instruction set architecture

- Flynn’s taxonomy

- SIMD within a register (SWAR)

- Single Program, Multiple Data (SPMD)

- OpenCL

References[edit]

- ^ Flynn, Michael J. (September 1972). «Some Computer Organizations and Their Effectiveness» (PDF). IEEE Transactions on Computers. C-21 (9): 948–960. doi:10.1109/TC.1972.5009071.

- ^ «MIMD1 — XP/S, CM-5» (PDF).

- ^ Conte, G.; Tommesani, S.; Zanichelli, F. (2000). «The long and winding road to high-performance image processing with MMX/SSE». Proc. Fifth IEEE Int’l Workshop on Computer Architectures for Machine Perception. doi:10.1109/CAMP.2000.875989. hdl:11381/2297671. S2CID 13180531.

- ^ Lee, R.B. (1995). «Realtime MPEG video via software decompression on a PA-RISC processor». digest of papers Compcon ’95. Technologies for the Information Superhighway. pp. 186–192. doi:10.1109/CMPCON.1995.512384. ISBN 0-8186-7029-0. S2CID 2262046.

- ^ Patterson, David; Waterman, Andrew (18 September 2017). «SIMD Instructions Considered Harmful». SIGARCH.

- ^ RE: SSE2 speed, showing how SSE2 is used to implement SHA hash algorithms

- ^ Salsa20 speed; Salsa20 software, showing a stream cipher implemented using SSE2

- ^ Subject: up to 1.4x RSA throughput using SSE2, showing RSA implemented using a non-SIMD SSE2 integer multiply instruction.

- ^ «SIMD library math functions». Stack Overflow. Retrieved 16 January 2020.

- ^ «Vector Extensions». Using the GNU Compiler Collection (GCC). Retrieved 16 January 2020.

- ^ «Clang Language Extensions». Clang 11 documentation. Retrieved 16 January 2020.

- ^ «VcDevel/std-simd». VcDevel. 6 August 2020.

- ^ «RyuJIT: The next-generation JIT compiler for .NET». 30 September 2013.

- ^ «The JIT finally proposed. JIT and SIMD are getting married». 7 April 2014.

- ^ «JEP 338: Vector API».

- ^ «SIMD Directives». www.openmp.org.

- ^ «Tutorial pragma simd». CilkPlus. 18 July 2012. Archived from the original on 4 December 2020. Retrieved 9 August 2020.

- ^ Kruse, Michael. «OMP5.1: Loop Transformations» (PDF).

- ^ «Function multi-versioning in GCC 6». lwn.net.

- ^ «2045-target-feature». The Rust RFC Book.

- ^ «Transparent use of library packages optimized for Intel® architecture». Clear Linux* Project. Retrieved 8 September 2019.

- ^ John McCutchan. «Bringing SIMD to the web via Dart» (PDF). Archived from the original (PDF) on 2013-12-03.

- ^ «SIMD in JavaScript». 01.org. 8 May 2014.

- ^ «tc39/ecmascript_simd: SIMD numeric type for EcmaScript». GitHub. Ecma TC39. 22 August 2019. Retrieved 8 September 2019.

- ^ Jensen, Peter; Jibaja, Ivan; Hu, Ningxin; Gohman, Dan; McCutchan, John (2015). «SIMD in JavaScript via C++ and Emscripten» (PDF).

- ^ «Porting SIMD code targeting WebAssembly». Emscripten 1.40.1 documentation.

- ^ «ZiiLABS ZMS-05 ARM 9 Media Processor». ZiiLabs. Archived from the original on 2011-07-18. Retrieved 2010-05-24.

External links[edit]

- SIMD architectures (2000)

- Cracking Open The Pentium 3 (1999)

- Short Vector Extensions in Commercial Microprocessor

- Article about Optimizing the Rendering Pipeline of Animated Models Using the Intel Streaming SIMD Extensions

- «Yeppp!»: cross-platform, open-source SIMD library from Georgia Tech

- Introduction to Parallel Computing from LLNL Lawrence Livermore National Laboratory Archived 2013-06-10 at the Wayback Machine

- simde on GitHub: A portable implementation of platform-specific intrinsics for other platforms (e.g. SSE intrinsics for ARM NEON), using C/C++ headers

Для одноименных статей см. Single .

Единая инструкция для нескольких данных (что на английском языке означает «одна инструкция, несколько данных»), или SIMD , является одной из четырех категорий архитектуры, определенных в таксономии Флинна в 1966 году, и обозначает режим работы компьютеров, наделенных мощностями. от параллельности . В этом режиме одна и та же инструкция применяется к нескольким данным одновременно для получения нескольких результатов.

Эта аббревиатура используется в противоположность SISD ( одна инструкция, отдельные данные ), традиционной операции, MIMD ( несколько инструкций, несколько данных ), работе с несколькими процессорами с независимой памятью или SPMD ( одна программа, несколько данных ). Существует также термин SIMT ( Single Instruction, Multiple Threads ), который является улучшением SIMD за счет его адаптации к многопоточным вычислениям .

Исторический

Определено систематике Флинна в 1966 году, один из первых приложений будет в Cray-1 суперкомпьютер в 1976 году .

В начале 1990 — х годов , в Macintosh микрокомпьютеры от компании Apple и BeBox были оснащены RISC PowerPC процессоров , они включали в себя fmadd инструкцию (стоя для плавающей умножения-сложения , то есть плавучий сложение-mulitiplication) и fmsub (с английского плавающей умножения-вычитания , означает плавающее вычитание-умножение), способный умножать два регистра, затем добавлять или вычитать из третьего и помещать результат в четвертый, они могут быть выбраны по желанию в регистрах с плавающей запятой двойной точности FPU . Эти, как и большинство других плавающих инструкций, используют процессоры с технологией RISC от трех до четырех тактовых циклов для своего выполнения, но до трех могут выполняться параллельно благодаря конвейерной системе.

в 8 января 1997 г., Intel выпускает первый микропроцессор с технологией MMX , Pentium MMX (P166MX) с тактовой частотой 166 МГц , это первый случай, когда SIMD был добавлен к процессору с технологией CISC . Позже, в 1997 году , AMD также выпустила MMX-совместимый процессор X86 (по лицензии Intel), включая дополнительный набор SIMD, 3DNow! В 1999 году Intel добавит новую игру SIMD с технологией SSE , несовместимой с 3DNow !.

VFP ARM вектор процессор представлен в SoC в 2000 — е годы , что позволило ввести их в мобильных телефонах и других мобильных устройствах с очень низким энергопотреблением. В 2009 году ARM представила новую линейку процессоров ARM Cortex-A , основанную на технологии NEON , с первой моделью Cortex-A8 , которая повысила производительность устройств этого типа.

Использовать

Модель SIMD особенно подходит для обработки, структура которой очень регулярна, как в случае матричных вычислений . Как правило, приложения, использующие архитектуры SIMD, — это те, которые используют множество массивов, матриц или подобных структур данных. В частности, можно упомянуть научные приложения или обработку сигналов.

Аппаратная реализация

Аппаратная реализация парадигмы SIMD может быть реализована различными способами:

- посредством использования инструкций SIMD, как правило, в микрокоде, интерпретируемом на CISC или связанном с RISC;

- на векторных процессорах ;

- от потоковых процессоров (EN) ;

- или через системы, содержащие многоядерные процессоры или несколько процессоров.

В первых трех случаях один процессор, естественно, может выполнять идентичную операцию с разными данными.

В последнем случае каждый процессор будет выполнять одну операцию с данными. Таким образом, параллелизм SIMD обусловлен использованием нескольких процессоров.

SIMD инструкции

Эти инструкции представляют собой инструкции, которые могут выполнять несколько операций параллельно с разными данными.

Рассматриваемые операции могут быть:

- побитовые операции, такие как и , или , не побитовые ;

- дополнения;

- вычитания;

- умножения;

- возможно подразделения;

- или более сложные математические операции.

Пример выполнения инструкции сложения вектора.

Все эти инструкции SIMD работают с набором данных одного размера и типа. Эти данные собираются в виде блоков данных фиксированного размера, называемых вектором. Эти векторы содержат несколько целых чисел или чисел с плавающей запятой, расположенных рядом друг с другом.

Инструкция SIMD будет обрабатывать все данные вектора независимо от других. Например, инструкция сложения SIMD суммирует данные, которые находятся в одном месте в двух векторах, и помещает результат в другой вектор в том же месте. При выполнении инструкции для вектора данные, присутствующие в этом векторе, обрабатываются одновременно.

Все современные процессоры содержат расширения своего набора команд, такие как MMX, SSE и т. Д. Эти расширения были добавлены в современные процессоры, чтобы повысить скорость обработки вычислений. Команды SIMD состоят, в частности, из наборов команд:

- На процессоре x86 : MMX , 3DNow! , SSE , SSE2 , SSE3 , SSSE3 , SSE4 , SSE4.1, SSE4.2, AVX , AVX2 и AVX512;

- На процессоре PowerPC : AltiVec ;

- На процессоре ARM : VFP , VFPv2, VFPv3lite, VFPv3, NEON , VFPv4;

- На процессоре SPARC : VIS и VIS2;

- На процессоре MIPS : MDMX и MIPS-3D.

Регистры SIMD

Векторы, обрабатываемые этими инструкциями, часто помещаются в отдельные регистры, специализирующиеся на хранении векторов. Часто они довольно большие по размеру, от 128 до 256 бит.

Однако некоторые процессоры используют свои общие регистры для хранения этих векторов. Следовательно, они не обязательно имеют специализированные регистры, а обычные регистры используются для поддержки векторов. Затем инструкции SIMD работают с теми же регистрами, что и их аналоги, не относящиеся к SIMD. Эта форма инструкций SIMD называется micro-SIMD.

Использовать для оптимизации

Программы, оптимизированные с помощью этого вида инструкций, требуют много ресурсов процессора: сжатие данных , кодек для воспроизведения звука и / или видео, вычисление больших целых чисел ( в частности, криптография ) и т. Д.

Обычно эти инструкции используются непосредственно программистами. Они пишут фрагменты ассемблерного кода в своих программах, чтобы иметь возможность максимально использовать оптимизацию, разрешенную инструкциями SIMD. Они начинают с разработки универсального кода, который будет работать везде. Когда алгоритм верен, они пишут специализированную версию для расширения данного процессора. Поэтому использование этих инструкций требует много работы и глубоких знаний сборки.

Некоторые компиляторы и некоторые библиотеки позволяют использовать эти оптимизации без программирования на ассемблере. Можно отметить, что проект Mono, например, выигрывает от этих оптимизаций процессора, если используются соответствующие классы. Однако следует отметить, что ручная оптимизация, выполняемая программистами, дает лучшие результаты, чем оптимизация, выполняемая компилятором.

Векторные процессоры

Векторные процессоры можно рассматривать как процессоры, включающие инструкции SIMD с некоторыми дополнительными улучшениями. Например, эти процессоры не накладывают ограничений на выравнивание инструкций SIMD доступа к памяти. Кроме того, инструкции доступа к памяти поддерживают дополнительные режимы доступа к памяти, такие как доступ с чересстрочной разверткой или методом разброса-сбора.

Обработка потока

Обработка потока , или путем расчета потока, допускает различные типы единиц для расчета, то есть то , что позволяет, например, стандартная библиотека вычисления OpenCL .

Программная парадигма

Чтобы облегчить использование архитектур SIMD, были изобретены различные языки. Эти языки стремятся сделать параллелизм данных более удобным для компиляторов.

В современных процедурных языках компиляторам сложно определить, работают ли операторы с независимыми данными или нет. В результате компиляторы могут упустить некоторые возможности использования инструкций SIMD или векторных инструкций. Чтобы избежать такой ситуации, насколько это возможно, были изобретены определенные языки SIMD.

Среди этих языков можно указать:

- Язык CUDA . Этот язык позволяет использовать графические карты для числовых вычислений , и есть много инструкций, которые работают с несколькими данными одновременно.

- Стандарт библиотеки вычислений OpenCL позволяет распараллеливать все доступные процессоры системы; CPU, GPU (или gpGPU), DSP, SIMD, FPU и т. Д.

- Библиотека OpenMP — это гетерогенная библиотека для параллельных вычислений, которая стала де-факто стандартом для архитектур, состоящих из нескольких компьютеров. Начиная с версии 4.0, он включает функции, специализирующиеся на использовании модулей SIMD.

- Программное обеспечение для численных расчетов, такое как Matlab , Maple , Octave или расширение Python SciPy , также позволяет вычислять матрицы с помощью операций SIMD.

- Наконец, мы можем сослаться на библиотеку BLAS, широко используемую в Fortran и C / C ++ для линейной алгебры . Эта библиотека предоставляет множество примитивов матричного исчисления и линейной алгебры, все из которых работают с несколькими данными ( матрицами или числами с плавающей запятой ).

Наконец, компиляторы, такие как GCC или LLVM (и CLANG), позволяют автоматически векторизовать циклы вычислений на большинстве существующих SIMD.

использованная литература

- ↑ (in) Использование векторных операций SIMD для повышения производительности кода приложений на маломощных платформах ARM и Intel , Университет Гриффита, Австралия.

- ↑ (in) Руководство пользователя микропроцессора PowerPC 603e RISC и семейства EM603e на IBM.com — глава «2.3.4.2.2 Инструкции умножения с плавающей запятой» на стр. 2-26 и глава «6.4.3 Время выполнения модуля с плавающей запятой» », Стр. 6-17

- ↑ http://www.hardware.fr/articles/847-14/impact-assembleur-x264.html

- ↑ (in) Опубликованы спецификации OpenMP 4.0

В статье рассказывается:

- Определение Big Data, или больших данных

- Сбор и хранение больших данных перед обработкой

- 3 главных принципа работы с большими данными

- 9 основных методов обработки больших данных

- Проблемы анализа и обработки большого объема данных

-

Пройди тест и узнай, какая сфера тебе подходит:

айти, дизайн или маркетинг.Бесплатно от Geekbrains

Обработка больших данных в настоящее время с помощью обычных программных методов и аппаратных средств совершенно нерациональна, а зачастую невозможна, так как этого не позволяет огромный объем имеющейся информации. Впрочем, несколько эффективных методов для проведения подобных операций все же существует. Хотя и тут есть свои сложности.

Для каждого конкретного случая необходимо выбирать наиболее подходящий способ обработки данных, только тогда результаты окажутся удовлетворительными: и с технологической, и с экономической точки зрения. О принципах и проблемах этого процесса мы подробно рассказали ниже.

Определение Big Data, или больших данных

К большим данным относят информацию, чей объем может быть свыше сотни терабайтов и петабайтов. Причем такая информация регулярно обновляется. В качестве примеров можно привести данные, поступающие из контакт-центров, медиа социальных сетей, данные о торгах фондовых бирж и т. п. Также в понятие «большие данные» иногда включают способы и методики их обработки.

Если же говорить о терминологии, то «Big Data» подразумевает не только данные как таковые, но и принципы обработки больших данных, возможность дальнейшего их использования, порядок обнаружения конкретного информационного блока в больших массивах. Вопросы, связанные с такими процессами, не теряют своей актуальности. Их решение носит важный характер для тех систем, которые многие годы генерировали и копили различную информацию.

Существуют критерии информации, определенные в 2001 году Meta Group, которые позволяют оценить, соответствуют ли данные понятию Big Data или нет:

- Volume (объем) — примерно 1 Петабайт и выше.

- Velocity (скорость) — генерация, поступление и обработка данных с высокой скоростью.

- Variety (разнообразие)— разнородность данных, различные форматы и возможное отсутствие структурированности.

Скачать

файл

Зачастую к этим параметрам добавляют еще два фактора:

- Variability (изменчивость) — разноплановая интенсивность поступления, которая влияет на выбор методик обработки.

- Value (значимость) — разница в уровне сложности получаемой информации. Так, данные, поступающие из сообщений в чат-боте интернет-магазинов, имеют один уровень сложности. А данные, которые выдают машины, отслеживающие сейсмическую активность планеты — совсем другой уровень.

Следует отметить, что такие формулировки весьма условны, т. к. четкого и единого определения не существует. Есть даже мнение о необходимости отказа от термина «Big Data», т. к. происходит подмена понятий и Big Data часто путают с другими продуктами.

Сбор и хранение больших данных перед обработкой

Ресурсы, выдающие большие данные могут быть весьма разнообразны. Например:

- интернет — социальные сети, блоки и сайты СМИ, интернет вещей (IoT) и т.п.;

- корпоративные источники — транзакции, архивы, базы данных и т. п.;

- устройства, собирающие информацию — GPS-сигналы автомобилей, метеорологическое оборудование и т.п.

Совокупность методик по сбору данных и саму операцию называют Data Mining. В качестве примеров сервисов, осуществляющих процесс сбора информации, можно привести: Qlik, Vertica, Power BI, Tableau. Формат данных, как уже говорилось выше, может быть разнообразным — видео, текст, таблицы, SAS.

Если в сжатой форме описывать процесс сбора и обработки большого массива данных, то стоит выделить основные этапы:

- постановка задачи для аналитической программы;

- программа осуществляет сбор данных с их параллельной подготовкой (декодировка, отсев мусора, удаление нерелевантной информации);

- выбор алгоритма анализа данных;

- обучение программы выбранному алгоритму с дальнейшим анализом обнаруженных закономерностей.

В большинстве случаев полученные необработанные данные хранятся в так называемом «озере данных» — Data Lake. Формат и уровень структуризации информации при этом может быть разнообразным:

- структурные (данные в виде строк и колонок);

- частично структурированные (логи, CSV, XML, JSON-файлы);

- неструктурированные (pdf-формат, формат документов и т. п.);

- бинарные (формат видео, аудио и изображения).

Инструментарий, позволяющий хранить и обрабатывать данные в Data Lake:

- Hadoop — пакет утилит и библиотек, используемый для построения систем, обрабатывающих, хранящих и анализирующих большие массивы нереляционных данных: данные датчиков, интернет-трафика, объектов JSON, файлов журналов, изображений и сообщений в соцсетях.

- HPPC (DAS) – суперкомпьютер, способный обрабатывать данные в режиме реального времени или в «пакетном состоянии». Реализован LexisNexis Risk Solutions.

- Storm — фреймворк Big Data, созданный для работы с информацией в режиме реального времени. Разработан на языке программирования Clojure.

- DataLake – помимо функции хранения, включает в себя и программную платформу (например, такую как Hadoop), а также определяет источники и методы пополнения данных, кластеры узлов хранения и обработки информации, управления, инструментов обучения. DataLake при необходимости масштабируется до многих сотен узлов без прекращения работы кластера.

Топ-30 самых востребованных и высокооплачиваемых профессий 2023

Поможет разобраться в актуальной ситуации на рынке труда

Подборка 50+ ресурсов об IT-сфере

Только лучшие телеграм-каналы, каналы Youtube, подкасты, форумы и многое другое для того, чтобы узнавать новое про IT

ТОП 50+ сервисов и приложений от Geekbrains

Безопасные и надежные программы для работы в наши дни

Уже скачали 20925

Месторасположение «озера», как правило, находится в облаке. Так, около 72 % компаний при работе с Big Data предпочитают собственным серверам облачные. Это связано с тем, что обработка больших баз данных требует серьезные вычислительные мощности, в то время как облако значительно снижает стоимость работ. Именно по этой причине компании выбирают облачные хранилища.

Облако имеет ряд преимуществ перед собственным дата-сервисом. Из-за того, что расчет предстоящей нагрузки на инфраструктуру затруднителен, то закупка оборудования не целесообразна. Аппаратура, купленная на случай востребованности в больших мощностях, может просто простаивать, принося убытки. Если же оборудование окажется недостаточным по мощности, то его ресурсов не хватит для полноценной работы.

Облако, напротив, не имеет ограничений по объему сохраняемых в нем данных. Следовательно, оно выгодно с точки зрения экономии средств для тех компаний, нагрузка которых быстро растет, а также бизнеса, связанного с тестами различных гипотез.

3 главных принципа работы с большими данными

Ключевыми положениями для работы с большими данными являются:

Горизонтальная адаптивность

Количество данных неограниченyо, поэтому обрабатывающая их система должна иметь способность к расширению: при возрастании объемов данных должно пропорционально увеличиваться количество оборудования для поддержания работоспособности всей системы.

Стабильность в работе при отказах

Горизонтальная адаптивность предполагает наличие большого числа машин в компьютерном узле. К примеру, кластер Hadoop насчитывает более 40 000 машин. Само собой, что периодически оборудование, изнашиваясь, будет подвержено поломкам. Системы обработки больших данных должны функционировать таким образом, чтобы безболезненно переживать возможные сбои.

Только до 25.05

Скачай подборку тестов, чтобы определить свои самые конкурентные скиллы

Список документов:

Чтобы получить файл, укажите e-mail:

Подтвердите, что вы не робот,

указав номер телефона:

Уже скачали 7503

Концентрация данных

В масштабных системах данные распределяются по большому количеству оборудования. Допустим, что местоположение данных — один сервер, а их обработка происходит на другом сервере. В этом случае затраты на передачу информации с одного сервера на другой могут превышать затраты на сам процесс обработки. Соответственно, чтобы этого избежать необходимо концентрировать данные на той же аппаратуре, на которой происходит обработка.

В настоящее время все системы, работающие с Big Data, соблюдают эти три положения. А чтобы их соблюдать, нужно разрабатывать соответствующие методики и технологии.

9 основных методов обработки больших данных

Принципы работы инструментов обработки больших данных могут иметь некоторые различия, которые зависят от исследуемой сферы.

- Машинное обучение

Этот метод анализ данных содержит в своей основе способность аналитической системы самостоятельно обучаться в процессе решения различных задач. Т.е. программе задается алгоритм, который позволяет ей учиться выявлять определенные закономерности. Сферы применения такого метода достаточно разнообразны — например, с помощью машинного обучения проводятся маркетинговые исследования, социальные сети предлагают подборку постов, происходит разработка медицинских программ.

- Нейросеть

Нейросеть используют для распознавания визуальных образов. Нейронные сети — это математические модели, отображенные программным кодом. Такие модели работают по принципу нейронной сети живого существа: получение информации — ее обработка и передача — выдача результата.

Нейросеть способна проделать работу за несколько десятков людей. Ее используют для развлечений, прогнозирования, обеспечения безопасности, медицинской диагностики и т. д. Т.е. в различных социальных и профессиональных областях.

- Технология Data Mining

Математик Григорий Пятецкий-Шапиро ввел этот термин в 1989 г. Метод подразумевает обнаружение определенных закономерностей в сырых данных с помощью интеллектуального анализа. Data Mining используют для:

- определения нетипичных данных в общем потоке информации посредством анализа отклонений;

- поиска идентичной информации в различных источниках с помощью ассоциаций;

- определения факторов влияния на заданный параметр через регрессионный анализ;

- распределения данных по группам со схожими характеристикам, т. е. классификация данных;

- разделения записей по заранее сформированным классам, т. е. кластеризация.

Читайте также

- Стратегия краудсорсинга

В некоторых ситуациях, когда нет экономической выгоды в разработке системы ИИ (искусственного интеллекта), для выполнения разовых работ привлекают большое количество людей. Они могут решить те задачи, с которыми компьютер не в состоянии справиться в одиночку. Примером может быть сбор и обработка данных социологического опроса. Такая информация может находиться в неоцифрованном виде, в ней могут быть допущены ошибки и сокращения. Такой формат будет понятен человеку, и он сможет организовать данные в тот вид, который будет читаем алгоритмами программ.

Однако, если речь идет о постоянном поиске решений подобных задач, то придется применять методы Data Mining или машинного обучения. Благодаря умению подводить математическую статистику или составлять имитационные модели, машины могут выполнять сложные аналитические процессы.

- Метод предиктивной аналитики

Другими словами, методика прогнозирования. Имея достаточный объем соответствующей информации, можно составить прогноз и ответить на вопрос «Как будут развиваться события?». Принцип предиктивной аналитики таков: сначала нужно исследовать данные за прошлый период; выявить закономерности или факторы, которые стали причиной результата; далее с помощью нейросети или математических вычислений создать модель, которая сможет производить прогнозирование.

Методика прогнозов используется в различных сферах. Например, предиктивная аналитика позволяет выявить и предотвратить мошеннические схемы в кредитовании или страховании. В медицине прогнозный анализ на основе данных о пациенте помогает определить его предрасположенность к каким-либо заболеваниям.

- Принцип статистического анализа

Суть метода заключается в сборе данных, их изучении на основе конкретных параметров и получении результата, выраженного, как правило, в процентах. У этого метода есть слабое звено — неточность данных в маленьких выборках. Поэтому для получения максимально точных результатов необходимо собирать большой объем исходных данных.

Статистический анализ часто используют как часть другого способа обработки больших данных Big Data, например, в машинном обучении или предиктивной аналитике.

Некоторые маркетинговые методы исследования, например, А/В тестирование относятся к статистической аналитике. A/B testing чаще всего используют для увеличения конверсии, а само тестирование складывается из сравнения двух групп: контрольной — не подвергающейся изменениям, и второй группы, на которую оказывали какое-либо влияние (например, ей показывали другой формат рекламы). Такое тестирование позволяет понять, что улучшает целевые показатели.

Для получения статистических показателей используют:

- корреляционный анализ для определения взаимозависимости показателей;

- процентное соотношение итогов анализа;

- динамические ряды для оценки интенсивности изменений определенных условий в конкретный интервал времени;

- определение среднего показателя.

- Технология имитационного моделирования

Имитационное моделирование отличается от методики прогнозирования тем, что берутся в учет факторы, чье влияние на результат затруднительно отследить в реальных условиях. Т.е. выстраиваются модели с учетом гипотетических, а не реальных данных, и затем эти модели исследуют в виртуальной реальности.

Метод имитационных моделей применяют для анализа влияния разных обстоятельств на итоговый показатель. Например, в сфере продаж таким образом исследуют воздействие изменения цены, наличия предложений со скидками, количества продавцов и прочих условий. Различные вариации изменений помогают определить наиболее эффективную модель маркетинговой стратегии для внедрения в практику. Для такого рода моделирования необходимо использовать большое число возможных факторов, чтобы снизить риски недостоверности результатов.

- Метод визуализации аналитических данных

Для удобства оценки результатов анализа применяют визуализацию данных. Для реализации этого метода, при условии работы с большими данными, используют виртуальную реальность и «большие экраны». Основной плюс визуализации в том, что такой формат данных воспринимается лучше, чем текстовый, ведь до 90 % всей информации человек усваивает с помощью зрения.

Результат анализа визуализируют в виде графиков, 3D-моделей, диаграмм и т. д. Инструментарий такого метода представлен платформами: Orange, Microsoft (Excel, Power BI), Microstrategy, Qlik, Tableau (tableau desktop, tableau public).

Метод визуализации аналитических данных позволяет быстро воспринять и сравнить, например, уровни продаж в разных регионах, или оценить зависимость объемов продаж от снижения/увеличения стоимости товара.

- Метод смешения и интеграции данных

В подавляющем большинстве случаев Big Data получают из различных источников, соответственно, данные имеют разнородный формат. Загружать такие данные в одну базу бессмысленно, так как их параметры не имеют взаимного соотношения. Именно в таких случаях применяют смешение и интеграцию, то есть приводят все данные к единому виду.

Читайте также

Для использования информации из различных источников применяют следующие методы:

- сведение данных в единый формат посредством конвертации документов, перевода текста в цифры, распознавание текста;

- информацию для одного объекта дополняют данными из разных источников;

- из лишней информации отфильтровывают и удаляют ту, которая недоступна для анализа.

После того как процесс интеграции завершен, следует анализ и обработка данных. В качестве примера метода интеграции и смешения данных можно рассмотреть: магазин, который ведет торговлю в нескольких направлениях — оффлайн-продажи, маркетплейс и одна из соцсетей. Чтобы провести полноценную оценку продаж и спроса, нужно собрать данные: о заказах через маркетплейс, товарные чеки оффлайн-продаж, заказы через соцсеть, остатки товара на складе и так далее.

Проблемы анализа и обработки большого объема данных

Основная проблема обработки большого массива данных лежит на поверхности — это высокие затраты. Здесь учитываются расходы на закупку, содержание и ремонт оборудования, а также заработанная плата специалистов, которые компетентны в работе с Big Data.

Следующая проблема связана с большим объемом информации, нуждающейся в обработке. Например, если в процессе исследования мы получаем не два-три результата, а многочисленное число возможных итогов, то крайне сложно выбрать именно те, которые будут иметь реальное воздействие на показатели определенного события.

Еще одна проблема — это приватность больших данных. Конфиденциальность может быть нарушена, так как все большее количество сервисов, связанное с обслуживанием клиентов, используют данные онлайн. Соответственно, это увеличивает рост киберпреступлений. Даже обычное хранение персональных данных клиентов в облаке может быть подвержено утечке. Вопрос сохранности личных данных — одна из важнейших задач, которую необходимо решать при использовании методик Big Data.

Угроза потери данных. Однократное резервирование не решает вопрос сохранения информации. Для хранилища необходимо создавать минимум две-три резервные копии. Но с ростом объемов данных увеличивается проблемность резервирования. Поэтому специалисты заняты поиском максимально результативного выхода из такой ситуации.

В заключение следует отметить, что развитие технологий обработки больших данных открывают широкие возможности для повышения эффективности различных сфер человеческой деятельности: медицины, транспортного обслуживания, государственного управления, финансов, производства. Именно это и определяет интенсивность развития данного направления в последние годы.

Что такое большие данные?

Самое простое определение

Из названия можно предположить, что термин `большие данные` относится просто к управлению и анализу больших объемов данных. Согласно отчету McKinsey Institute `Большие данные: новый рубеж для инноваций, конкуренции и производительности` ( Big data: The next frontier for innovation, competition and productivity), термин `большие данные` относится к наборам данных, размер которых превосходит возможности типичных баз данных (БД) по занесению, хранению, управлению и анализу информации. И мировые репозитарии данных, безусловно, продолжают расти. В представленном в середине 2011 г. отчете аналитической компании IDC `Исследование цифровой вселенной` (Digital Universe Study), подготовку которого спонсировала компания EMC, предсказывалось, что общий мировой объем созданных и реплицированных данных в 2011-м может составить около 1,8 зеттабайта (1,8 трлн. гигабайт) — примерно в 9 раз больше того, что было создано в 2006-м.

IDC, Nexus of Forces Gartner

Традиционная база данных и База Больших Данных

Более сложное определение

Тем не менее `большие данные` предполагают нечто большее, чем просто анализ огромных объемов информации. Проблема не в том, что организации создают огромные объемы данных, а в том, что бóльшая их часть представлена в формате, плохо соответствующем традиционному структурированному формату БД, — это веб-журналы, видеозаписи, текстовые документы, машинный код или, например, геопространственные данные. Всё это хранится во множестве разнообразных хранилищ, иногда даже за пределами организации. В результате корпорации могут иметь доступ к огромному объему своих данных и не иметь необходимых инструментов, чтобы установить взаимосвязи между этими данными и сделать на их основе значимые выводы. Добавьте сюда то обстоятельство, что данные сейчас обновляются все чаще и чаще, и вы получите ситуацию, в которой традиционные методы анализа информации не могут угнаться за огромными объемами постоянно обновляемых данных, что в итоге и открывает дорогу технологиям больших данных.

Наилучшее определение

В сущности понятие больших данных подразумевает работу с информацией огромного объема и разнообразного состава, весьма часто обновляемой и находящейся в разных источниках в целях увеличения эффективности работы, создания новых продуктов и повышения конкурентоспособности. Консалтинговая компания Forrester дает краткую формулировку: `Большие данные объединяют техники и технологии, которые извлекают смысл из данных на экстремальном пределе практичности`.

Насколько велика разница между бизнес-аналитикой и большими данными?

Крейг Бати, исполнительный директор по маркетингу и директор по технологиям Fujitsu Australia, указывал, что бизнес-анализ является описательным процессом анализа результатов, достигнутых бизнесом в определенный период времени, между тем как скорость обработки больших данных позволяет сделать анализ предсказательным, способным предлагать бизнесу рекомендации на будущее. Технологии больших данных позволяют также анализировать больше типов данных в сравнении с инструментами бизнес-аналитики, что дает возможность фокусироваться не только на структурированных хранилищах.

Мэтт Слокум из O’Reilly Radar считает, что хотя большие данные и бизнес-аналитика имеют одинаковую цель (поиск ответов на вопрос), они отличаются друг от друга по трем аспектам.

- Большие данные предназначены для обработки более значительных объемов информации, чем бизнес-аналитика, и это, конечно, соответствует традиционному определению больших данных.

- Большие данные предназначены для обработки более быстро получаемых и меняющихся сведений, что означает глубокое исследование и интерактивность. В некоторых случаях результаты формируются быстрее, чем загружается веб-страница.

- Большие данные предназначены для обработки неструктурированных данных, способы использования которых мы только начинаем изучать после того, как смогли наладить их сбор и хранение, и нам требуются алгоритмы и возможность диалога для облегчения поиска тенденций, содержащихся внутри этих массивов.

Согласно опубликованной компанией Oracle белой книге `Информационная архитектура Oracle: руководство архитектора по большим данным` (Oracle Information Architecture: An Architect’s Guide to Big Data), при работе с большими данными мы подходим к информации иначе, чем при проведении бизнес-анализа.

Работа с большими данными не похожа на обычный процесс бизнес-аналитики, где простое сложение известных значений приносит результат: например, итог сложения данных об оплаченных счетах становится объемом продаж за год. При работе с большими данными результат получается в процессе их очистки путём последовательного моделирования: сначала выдвигается гипотеза, строится статистическая, визуальная или семантическая модель, на ее основании проверяется верность выдвинутой гипотезы и затем выдвигается следующая. Этот процесс требует от исследователя либо интерпретации визуальных значений или составления интерактивных запросов на основе знаний, либо разработки адаптивных алгоритмов `машинного обучения`, способных получить искомый результат. Причём время жизни такого алгоритма может быть довольно коротким.

Big Data≠Data Science

- ETLELT

- Технологии хранения больших объемов структурированных и не структурированных данных

- Технологии обработки таких данных

- Управление качеством данных

- Технологии предоставления данных потребителю

Data Science – это:

- Распознавание видео

- Распознавание текстов

- Распознавание речи

- Построение рекомендательных моделей

- Сегментация

- Кластеризация и т.д.

Методики анализа больших данных

Существует множество разнообразных методик анализа массивов данных, в основе которых лежит инструментарий, заимствованный из статистики и информатики (например, машинное обучение). Список не претендует на полноту, однако в нем отражены наиболее востребованные в различных отраслях подходы. При этом следует понимать, что исследователи продолжают работать над созданием новых методик и совершенствованием существующих. Кроме того, некоторые из перечисленных них методик вовсе не обязательно применимы исключительно к большим данным и могут с успехом использоваться для меньших по объему массивов (например, A/B-тестирование, регрессионный анализ). Безусловно, чем более объемный и диверсифицируемый массив подвергается анализу, тем более точные и релевантные данные удается получить на выходе.

A/B testing. Методика, в которой контрольная выборка поочередно сравнивается с другими. Тем самым удается выявить оптимальную комбинацию показателей для достижения, например, наилучшей ответной реакции потребителей на маркетинговое предложение. Большие данные позволяют провести огромное количество итераций и таким образом получить статистически достоверный результат.

Association rule learning. Набор методик для выявления взаимосвязей, т.е. ассоциативных правил, между переменными величинами в больших массивах данных. Используется в data mining.

Classification. Набор методик, которые позволяет предсказать поведение потребителей в определенном сегменте рынка (принятие решений о покупке, отток, объем потребления и проч.). Используется в data mining.

Cluster analysis. Статистический метод классификации объектов по группам за счет выявления наперед не известных общих признаков. Используется в data mining.

Crowdsourcing. Методика сбора данных из большого количества источников.

Data fusion and data integration. Набор методик, который позволяет анализировать комментарии пользователей социальных сетей и сопоставлять с результатами продаж в режиме реального времени.

Data mining. Набор методик, который позволяет определить наиболее восприимчивые для продвигаемого продукта или услуги категории потребителей, выявить особенности наиболее успешных работников, предсказать поведенческую модель потребителей.

Ensemble learning. В этом методе задействуется множество предикативных моделей за счет чего повышается качество сделанных прогнозов.

Genetic algorithms. В этой методике возможные решения представляют в виде `хромосом`, которые могут комбинироваться и мутировать. Как и в процессе естественной эволюции, выживает наиболее приспособленная особь.

Machine learning. Направление в информатике (исторически за ним закрепилось название `искусственный интеллект`), которое преследует цель создания алгоритмов самообучения на основе анализа эмпирических данных.

Natural language processing (NLP). Набор заимствованных из информатики и лингвистики методик распознавания естественного языка человека.

Network analysis. Набор методик анализа связей между узлами в сетях. Применительно к социальным сетям позволяет анализировать взаимосвязи между отдельными пользователями, компаниями, сообществами и т.п.

Optimization. Набор численных методов для редизайна сложных систем и процессов для улучшения одного или нескольких показателей. Помогает в принятии стратегических решений, например, состава выводимой на рынок продуктовой линейки, проведении инвестиционного анализа и проч.

Pattern recognition. Набор методик с элементами самообучения для предсказания поведенческой модели потребителей.

Predictive modeling. Набор методик, которые позволяют создать математическую модель наперед заданного вероятного сценария развития событий. Например, анализ базы данных CRM-системы на предмет возможных условий, которые подтолкнут абоненты сменить провайдера.

Regression. Набор статистических методов для выявления закономерности между изменением зависимой переменной и одной или несколькими независимыми. Часто применяется для прогнозирования и предсказаний. Используется в data mining.

Sentiment analysis. В основе методик оценки настроений потребителей лежат технологии распознавания естественного языка человека. Они позволяют вычленить из общего информационного потока сообщения, связанные с интересующим предметом (например, потребительским продуктом). Далее оценить полярность суждения (позитивное или негативное), степень эмоциональности и проч.

Signal processing. Заимствованный из радиотехники набор методик, который преследует цель распознавания сигнала на фоне шума и его дальнейшего анализа.

Spatial analysis. Набор отчасти заимствованных из статистики методик анализа пространственных данных – топологии местности, географических координат, геометрии объектов. Источником больших данных в этом случае часто выступают геоинформационные системы (ГИС).

Statistics. Наука о сборе, организации и интерпретации данных, включая разработку опросников и проведение экспериментов. Статистические методы часто применяются для оценочных суждений о взаимосвязях между теми или иными событиями.

Supervised learning. Набор основанных на технологиях машинного обучения методик, которые позволяют выявить функциональные взаимосвязи в анализируемых массивах данных.

Simulation. Моделирование поведения сложных систем часто используется для прогнозирования, предсказания и проработки различных сценариев при планировании.

Time series analysis. Набор заимствованных из статистики и цифровой обработки сигналов методов анализа повторяющихся с течением времени последовательностей данных. Одни из очевидных применений – отслеживание рынка ценных бумаг или заболеваемости пациентов.

Unsupervised learning. Набор основанных на технологиях машинного обучения методик, которые позволяют выявить скрытые функциональные взаимосвязи в анализируемых массивах данных. Имеет общие черты с Cluster Analysis.

Визуализация. Методы графического представления результатов анализа больших данных в виде диаграмм или анимированных изображений для упрощения интерпретации облегчения понимания полученных результатов.

Наглядное представление результатов анализа больших данных имеет принципиальное значение для их интерпретации. Не секрет, что восприятие человека ограничено, и ученые продолжают вести исследования в области совершенствования современных методов представления данных в виде изображений, диаграмм или анимаций.

Аналитический инструментарий

На 2011 год некоторые из перечисленных в предыдущем подразделе подходов или определенную их совокупность позволяют реализовать на практике аналитические движки для работы с большими данными. Из свободных или относительно недорогих открытых систем анализа Big Data можно порекомендовать:[1]

- 1010data;

- Apache Chukwa;

- Apache Hadoop;

- Apache Hive;

- Apache Pig!;

- Jaspersoft;

- LexisNexis Risk Solutions HPCC Systems;

- MapReduce;

- Revolution Analytics (на базе языка R для мат.статистики).

Особый интерес в этом списке представляет Apache Hadoop – ПО с открытым кодом, которое за последние пять лет испытано в качестве анализатора данных большинством трекеров акций[2]. Как только Yahoo открыла код Hadoop сообществу с открытым кодом, в ИТ-индустрии незамедлительно появилось целое направление по созданию продуктов на базе Hadoop. Практически все современные средства анализа больших данных предоставляют средства интеграции с Hadoop. Их разработчиками выступают как стартапы, так и общеизвестные мировые компании.

Рынки решений для управления большими данными

Платформы больших данных (BDP, Big Data Platform) как средство борьбы с цифровым хордингом

Возможность анализировать большие данные, в просторечии называемая Big Data, воспринимается как благо, причем однозначно. Но так ли это на самом деле? К чему может привести безудержное накопление данных? Скорее всего к тому, что отечественные психологи применительно к человеку называют патологическим накопительством, силлогоманией или образно «синдромом Плюшкина». По-английски порочная страсть собирать все подряд называют хордингом (от англ. hoard – «запас»). По классификации ментальных заболеваний хординг причислен к психическим расстройствам. В цифровую эпоху к традиционному вещественному хордингу добавляется цифровой (Digital Hoarding), им могут страдать как отдельные личности, так и целые предприятия и организации (подробнее).

Мировой и рынок России

- Большие данные в России

- Большие данные (Big Data) мировой рынок

- Большие данные как услуга (BDaaS)

Big data Landscape — Основные поставщики

Интерес к инструментам сбора, обработки, управления и анализа больших данных проявляли едва ли не все ведущие ИТ-компании, что вполне закономерно. Во-первых, они непосредственно сталкиваются с этим феноменом в собственном бизнесе, во-вторых, большие данные открывают отличные возможности для освоения новых ниш рынка и привлечения новых заказчиков.

- Amazon

- Dell

- eBay

- EMC

- Fujitsu

- HDS (Hitachi Data Systems Corporation) Хитачи Вантара

- HP

- IBM

- Microsoft

- NetApp

- Oracle

- SAP

- SAS

- SGI (Silicon Graphics Inc)

- Teradata

- VMware

- Yahoo

На рынке появлялось множество стартапов, которые делают бизнес на обработке огромных массивов данных. Часть из них используют готовую облачную инфраструктуру, предоставляемую крупными игроками вроде Amazon.

- Acunu

- Apigee

- Aspera

- Aster Data (поглотила Teradata)

- Cloudera

- Couchbase

- Datameer

- DataStax

- Factual

- GoodData

- Greenplum (поглотила ЕМС)

- Hortonworks (имеет общие корни с Yahoo)

- MapR Technologies

- Metaweb Technologies (поглотила Google)

- Netezza (поглотила IBM)

- nPario

- Palantir Technologies

- ParAccel

- ParStream

- SenSage

- Socrata

- Splunk

- Sybase (поглотила SAP)

- TellApart

- Vertica (поглотила НР)

Теория и практика Больших данных в отраслях

Основная статья — Теория и практика Больших данных в отраслях.

Как использовать аналитические данные для разработки качественных ИТ-сервисов

Основная статья — Использование аналитических данных для разработки ИТ-сервисов

История развития

2017

Прогноз TmaxSoft: следующая «волна» Big Data потребует модернизации СУБД

Согласно отчету IDC, в связи ростом объемов данных, генерируемых подключенными к интернету устройствами, датчиками и другими технологиями, доходы, связанные с большими данными, увеличатся со $130 млрд в 2016 году до более чем $203 млрд к 2020 году.[3] Однако те компании, у которых нет ИТ-инфраструктуры, необходимой для адаптации к революции больших данных, не смогут получить выгоду от этого роста, считают эксперты компании TmaxSoft.

Предприятиям известно, что в накопленных ими огромных объемах данных содержится важная информация об их бизнесе и клиентах. Если компания сможет успешно применить эту информацию, то у нее будет значительное преимущество по сравнению с конкурентами, и она сможет предложить лучшие, чем у них, продукты и сервисы. Однако многие организации всё еще не могут эффективно использовать большие данные из-за того, что их унаследованная ИТ-инфраструктура неспособна обеспечить необходимую емкость систем хранения, процессы обмена данных, утилиты и приложения, необходимые для обработки и анализа больших массивов неструктурированных данных для извлечения из них ценной информации, указали в TmaxSoft.

Кроме того, увеличение процессорной мощности, необходимой для анализа постоянно увеличивающихся объемов данных, может потребовать значительных инвестиций в устаревшую ИТ-инфраструктуру организации, а также дополнительных ресурсов для сопровождения, которые можно было бы использовать для разработки новых приложений и сервисов.

По мнению Андрея Ревы, исполнительного директора TmaxSoft Россия, эти факторы приведут к тому, что организации, которые продолжают использовать унаследованную инфраструктуру, в будущем будут вынуждены заплатить намного больше за переход на актуальные технологии либо не смогут получить никакого эффекта от революции больших данных.

|

|

Феномен больших данных заставил многие предприятия осознать необходимость сбора, анализа и хранения структурированных и неструктурированных данных. Однако для внедрения этих процессов нужен план действий и правильные инструменты оптимизации процессов. А реально получать ощутимый эффект от больших данных многие компании не в состоянии из-за использования унаследованных СУБД, в которых не хватает функциональности и масштабируемости, и в результате революция больших данных никак не помогает их бизнесу, — пояснил свой прогноз Андрей Рева. |

|

По убеждению представителя TmaxSoft, предприятиям нужна стратегия, учитывающая, среди прочего, источники данных для извлечения, жизненный цикл данных, совместимость разных реляционных СУБД и масштабируемость хранения.

2016

Прогноз EMC: BigData и аналитика в реальном времени объединятся

В 2016 году мы познакомимся с новой главой истории развития аналитики «больших данных» по мере развития двухуровневой модели обработки. Первый уровень будет представлять собой «традиционную» аналитику BigData, когда большие массивы данных подвергаются анализу не в режиме реального времени. Новый, второй уровень обеспечит возможность анализа относительно больших объемов данных в реальном времени, в основном за счет технологий аналитики в памяти (in-memory). В этой новой фазе развития BigData, такие технологии как DSSD, Apache Spark и GemFire будут столь же важны, как Hadoop. Второй уровень предложит нам одновременно новые и привычные способы использования «озер данных» — для «аналитики на лету» с целью влияния на события, в то время, когда они происходят. Это открывает новые возможности для бизнеса в таких масштабах, которых раньше никто не видел.

Но для того, чтобы аналитика в памяти стала реальностью, необходимо, чтобы произошло два события. Во-первых, поддерживающие технологии должны получить необходимое развитие, чтобы обеспечить достаточные объемы памяти для размещения действительно масштабных наборов данных. Также нужно подумать о том, как эффективно перемещать данные между большими объектными хранилищами и системами, ведущими анализ в памяти. Ведь эти два элемента работают в принципиально разных режимах, и ИТ-группам нужно будет создать особые условия, чтобы данные могли перемещаться туда и обратно с нужной скоростью и прозрачно для пользователей. Работы уже ведутся, появляются новые объектные хранилища, специальные флеш-массивы для монтажа в стойку, а также специальные технологии, которые могут объединить их в одну систему. Инициативы с открытым кодом будут играть важную роль в поиске ответа на этот вызов.

Во-вторых, масштабные среды вычислений в памяти требуют устойчивости и динамичности данных. Проблема состоит в том, что обеспечивая персистентность данных в памяти, мы делаем устойчивыми также любые их дефекты. В результате в 2016 году мы увидим появления систем хранения для сред, проводящих обработку данных в памяти. Они будут предоставлять сервисы дедупликации, снимков состояния, многоуровневого хранения, кеширования, репликации, а также возможность определения последнего состояния, когда данные были верными и система работала корректно. Эти функции будут крайне важны по мере перехода к аналитике в реальном времени, когда более безопасные технологии обработки данных в памяти станут коммерческими в 2016 году.

2015

Gartner исключила «Большие данные» из популярных трендов

6 октября 2015 года стало известно об исключении из отчета Gartner «Цикл зрелости технологий 2015» сведений о больших данных. Исследователи объяснили это размыванием термина — входящие в понятие «большие данные» технологии стали повседневной реальностью бизнеса[4].

Отчет Gartner «Цикл зрелости технологий» (Hype Cycle for Emerging Technologies) взбудоражил отрасль отсутствием технологии сбора и обработки больших массивов данных. Свое решение аналитики компании объяснили тем, что в состав понятия «большие данные» входит большое количество технологий, активно применяющихся на предприятиях, они частично относятся к другим популярным сферам и тенденциям и стали повседневным рабочим инструментом.

Диаграмма Gartner «Hype Cycle for Emerging Technologies 2015»

«Изначально понятие «большие данные» расшифровывали через определение из трех «V»: volume, velocity, variety. Под этим термином подразумевалась группа технологий хранения, обработки и анализа данных большого объема, с изменчивой структурой и высокой скоростью обновления. Но реальность показала, что получение выгоды в бизнес-проектах осуществляется по тем же принципам, что и раньше. А описываемые технологические решения сами по себе не создали никакой новой ценности, лишь ускорив обработку большого количества данных. Ожидания были очень высокие, и список технологий больших данных интенсивно рос. Очевидно, что вследствие этого границы понятия размылись до предела», — поведал Святослав Штумпф, главный эксперт группы маркетинга продуктов «Петер-Сервис».

Дмитрий Шепелявый, заместитель генерального директора SAP CIS (САП СНГ), считает — тема больших данных не исчезла, а трансформировалась во множество различных сценариев:

«Примерами здесь могут быть ремонты по состоянию, точное земледелие (precision farming), системы по противодействию мошенничеству, системы в медицине, позволяющие на качественно новом уровне диагностировать и лечить пациентов. А также планирование логистической системы и транспортировки в режиме реального времени, усовершенствованная бизнес-аналитика для поддержки и сопровождения основных функций компаний. Один из основных трендов сейчас — Интернет вещей, позволяющий связывать машины между собой (machine-to-machine). Устанавливаемые электронные датчики производят миллионы транзакций в секунду, и необходимо надежное решение, способное трансформировать, сохранить и работать с ними в режиме реального времени».

В мае 2015 года Эндрю Уайт (Andrew White), вице-президент по исследованиям Gartner, в своем блоге размышлял:

«[[Интернет вещей Internet of Things (IoT)|Интернет вещей (Internet of Things, IoT)]] затмит собой большие данные, как слишком сфокусированную технологию. Она может породить еще несколько эффективных решений и инструментов, но платформой будущего, которая в долгосрочной перспективе повысит нашу продуктивность, станет именно интернет вещей».

Аналогичные идеи раньше — по результатам отчета Gartner за 2014 год, опубликовал обозреватель Forbes Гил Пресс (Gil Press).

По мнению Дмитрия Шепелявого, наступила эпоха, когда важно не просто уметь аккумулировать информацию, а извлекать из нее бизнес-выгоду. Первыми к этому выводу пришли индустрии, которые непосредственно работают с потребителем: телекоммуникационная и банковская, ритейл. Теперь процессы взаимодействия выходят на новый уровень, позволяя наладить связь между различными устройствами с использованием инструментов дополненной реальности и открывают новые возможности оптимизации бизнес-процессов компаний.

«Понятие «большие данные» потеряло интерес для реального бизнеса, на диаграмме Gartner его место заняли другие технологии с более четким и понятным бизнесу звучанием», — подчеркнул Святослав Штумпф.